目次 (2.1.システムへのログイン)

2.1. システムへのログイン

2.1.1. インターネットからのSSH接続によるログイン

2.1.1.1. 事前準備(秘密鍵・公開鍵の作成と登録)

2.1.1.2. ログインサーバへのSSH接続

2.1.1.3. 共用フロントエンドサーバへの接続

2.1.1.4. SCPファイル転送

①事前準備(秘密鍵の変換)

②SCPによるファイル転送(WinSCP使用)

2.1.1.5. X Window Systemを利用するアプリケーションの使用方法(Windows環境)

2.1.1.6. インターネットからのSSH多段接続によるログイン方法

・proxy設定によるSSH多段接続の設定方法

・Tera Termマクロ を使ったSSH多段接続の設定方法

・SCPによるファイル転送(インターネットからのSSH多段接続)

2.1.2. インターネットからのSSL-VPN接続による利用方法

2.1.2.1. SSL-VPN接続によるログイン

2.1.2.2. SSL-VPN接続によるSCPファイル転送(WinSCP使用)

2.1.2.3. X Window Systemを利用するアプリケーションの使用

2.1.3. 高度計算科学研究支援センター内でのログイン方法

▲このページの先頭へ

2.1.システムへのログイン

インターネットから、FOCUSスパコンシステムにログインするには、SSH鍵交換による接続法とSSL-VPNによる接続法の2経路があります。接続サーバ名等は、「付録A.FOCUSスパコンシステム各種サーバ・ストレージ概要」をご参照ください。

以下では、ログインの詳細な方法を記述します。

2.1.1.インターネットからのSSH接続によるログイン

お手元のマシンがインターネットに対してSSH接続できる環境であれば、SSH接続によりセンター内のシステムにアクセスすることができます。

以下の『2.1.1.1 事前準備(秘密鍵・公開鍵の作成と登録)』を実施して、公開鍵の登録が完了した後、ログインサーバ経由で共用フロントエンドサーバに接続できます。

図2.1.1 SSH接続イメージ

お手元のマシン

(localhost) |

→ インターネット → |

ログインサーバ

(ssh.j-focus.jp) |

→ |

共用フロントエンドサーバ

(ff.j-focus.jp) |

▲このページの先頭へ

2.1.1.1.事前準備(秘密鍵・公開鍵の作成と登録)

(1) スタートメニュー[すべてのプログラム]→[Tera Term]を順に選択します。

(2) Tera Term『新しい接続』画面で[キャンセル]ボタンをクリックします。

(『新しい接続』画面を閉じます。)

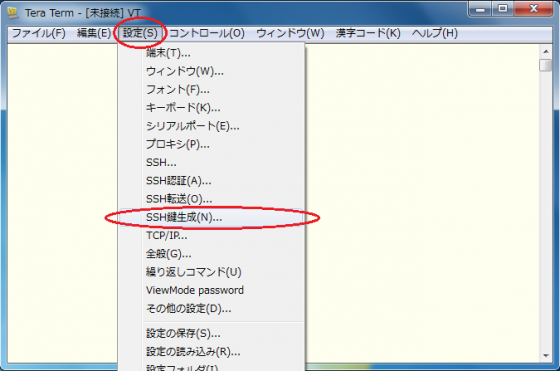

(3) Tera Termメニュー[設定]→[SSH鍵生成]を順に選択します。

(4)『TTSSH: 鍵生成』画面で、鍵の種類「RSA」(RSA2)を選択し、[生成]ボタンをクリックします。

(注)鍵の種類「RSA1、RSA、DSA」の中央に位置する“RSA”がRSA2です。

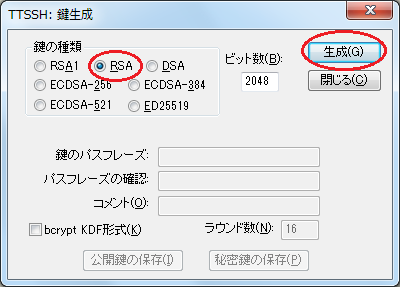

(5)「鍵のパスフレーズ」と「パスフレーズの確認」に同じフレーズを入力し、[公開鍵の保存]ボタンと[秘密鍵の保存]ボタンを押し、公開鍵と秘密鍵を保存します。

(6) OKBiz(https://secure.okbiz.okwave.jp/focus/)で公開鍵(id_rsa.pub)の登録を依頼します。

※ファイル名の初期値は次のとおりです。

・公開鍵:id_rsa.pub ←OKBizに添付するのは“.pub”の方です。

・秘密鍵:id_rsa ←お手元で管理してください(添付しないでください)。

※秘密鍵はSSH接続する際に使用します。

※秘密鍵はお手元で厳重に管理をお願いします(絶対に公開鍵と一緒に送付しないで下さい)。

※OKBizが使用不可の場合はメールで業務運用グループ unyo@j-focus.or.jpに送付してください。

▲このページの先頭へ

2.1.1.2.ログインサーバへのSSH接続

前述の手順『2.1.1.1. 事前準備(秘密鍵・公開鍵の作成と登録)』で作成した秘密鍵を使って、インターネットからログインサーバに対してSSH接続を行います。SSH接続に関わる各種情報は次のとおりです。

|

接続先 |

ssh.j-focus.jp |

|

サービス |

SSH |

|

ポート番号 |

22 |

|

サービスバージョン |

SSH2 |

|

認証方式 |

公開鍵認証 |

ご使用の環境によってはプロキシを設定する必要があります。そのような場合は、ご所属のネットワーク管理者にご確認ください。

手順は次のとおりです。

(1) スタートメニュー[すべてのプログラム]→[Tera Term]を選択します。

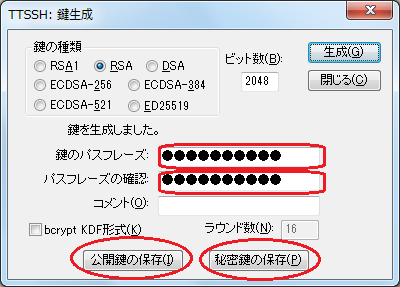

(2) TeraTerm『新しい接続』画面で以下の指定を行い、[OK]ボタンを押します。

|

・ホスト名 |

ssh.j-focus.jp |

|

・サービス |

SSH |

|

TCPポート# |

22 |

|

・SSHバージョン |

SSH2 |

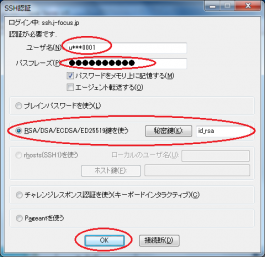

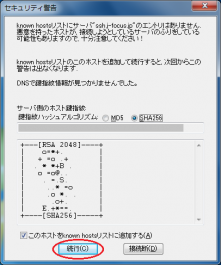

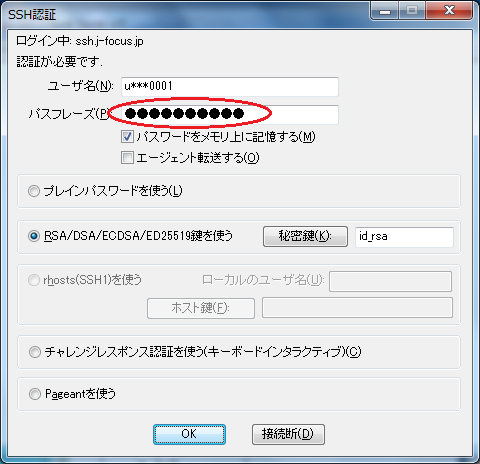

(3) 『SSH認証』画面で以下の指定を行い、[OK]ボタンを押します。

なお、セキュリティ警告ウィンドウが現れた場合は、[続行]ボタンを押します。

|

・ユーザ名 |

センターから発行されたアカウント名(「u」+“課題名”+数字4桁) |

|

・パスフレーズ |

公開鍵・秘密鍵を作成した際に指定したパスフレーズ |

|

・RSA/DSA鍵を使う |

チェックを入れる |

|

・秘密鍵 |

お手元のマシンに保存している秘密鍵ファイル |

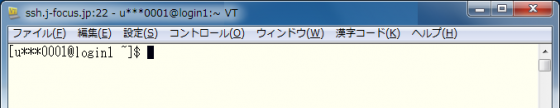

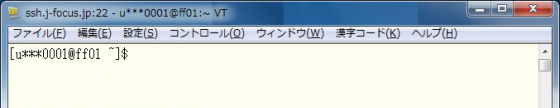

(4) プロンプト([アカウント名@login1~]$ もしくは[アカウント名@login2~]$)が表示されることを確認します。

▲このページの先頭へ

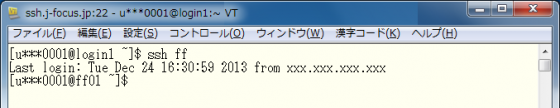

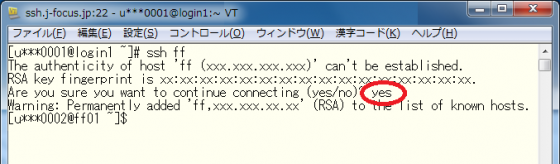

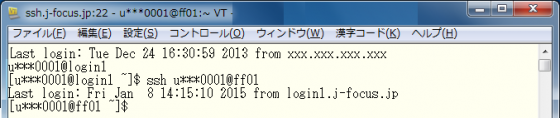

2.1.1.3.共用フロントエンドサーバへの接続

sshコマンドにより共用フロントエンドサーバff.j-focus.jp(ff)に接続します。

共用フロントエンド(ff01/ff02)上では、プログラムの開発、小規模な解析・デバッグ、

小規模なプリポスト処理の実行が許可されます。

ユーザーは下記の範囲での実行が可能です。

・CPU時間 1時間 (1時間で強制終了となります)

・プロセス数 1プロセス(並列実行、複数プロセスの起動は禁止です)

・利用メモリ 1GB程度 (小規模処理のみ許可)

上記範囲を越える場合は、バッチ処理より演算ノード上でジョブを実行してください。

または、専用フロントエンド(有償)の利用をご検討ください。

※専用フロントエンド上でのジョブ実行については、

実行時間、数、規模の制限はありません。(別途、申請書の提出が必要です)

【ffへの接続】

なお、初回接続時は確認メッセージが表示されるので、「yes」を入力します。

また、異なるアカウント名で接続する場合は、sshコマンドの -lオプションを使ってアカウント名を指定します。

【ffへの接続(アカウント指定あり)】

▲このページの先頭へ

2.1.1.4.SCPファイル転送

インターネットからログインサーバに対して、SCPファイル転送を行います。事前準備として秘密鍵の変換操作が必要となりますので、次の①、②の順で操作を行います。

①事前準備(秘密鍵の変換)・・・ PuTTY Key Generator(PuTTYgen)使用

②SCPファイル転送・・・ WinSCP

ホーム領域(/home1)は、ログインサーバと共用フロントエンドサーバが同じファイルシステムをマウントしているため、ファイルの転送操作はログインサーバに対してのみ実施します。

図2.1.1.4.1 ホーム領域(/home1)接続イメージ

お手元の

マシン

(localhost) |

→→

SCP |

インター

ネット |

→ |

ログインサーバ

(ssh.j-focus.jp) |

→ |

共用フロントエンド

サーバ

(ff.j-focus.jp) |

→→→→→

(マウント) |

ストレージ領域

/home1/グループ名

/home1/グループ名/アカウント名

/home1/グループ名/share |

→→→→→→→→→→→→→→→

(マウント) |

追加ストレージ領域(/home2)は、初期状態では共用フロントエンドサーバのみがマウントしています。ログインサーバからのマウントには、ユーザ単位での申請が必要となります。

図2.1.1.4.2 追加ストレージ領域(/home2)接続イメージ

お手元の

マシン

(localhost) |

→→

SCP |

インター

ネット |

→ |

ログインサーバ

(ssh.j-focus.jp) |

→ |

共用フロントエンド

サーバ

(ff.j-focus.jp) |

→→→→→

(マウント) |

ストレージ領域

/home2/グループ名(追加契約時) |

→→→→→→→→→→→→→→→

(マウントには申請が必要です)

|

なお、ご使用の環境によってはプロキシを設定する必要があります。そのような場合は、ご所属のネットワーク管理者にご確認ください。

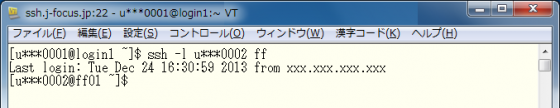

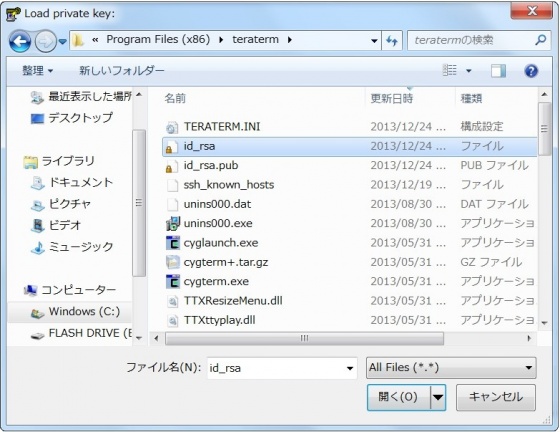

①事前準備(秘密鍵の変換)

WinSCP用に秘密鍵をPuTTY形式に変換します。前述『2.1.1.1 事前準備(秘密鍵・公開鍵の作成と登録)』の手順で作成した秘密鍵(id_rsa)を使います。

(1) スタートメニュー[すべてのプログラム]→[WinSCP]→『ログイン - WinSCP』画面で[ツール]→[PuTTYgenを実行]を順に選択します。

(PuTTY Key Generatorを起動します。)

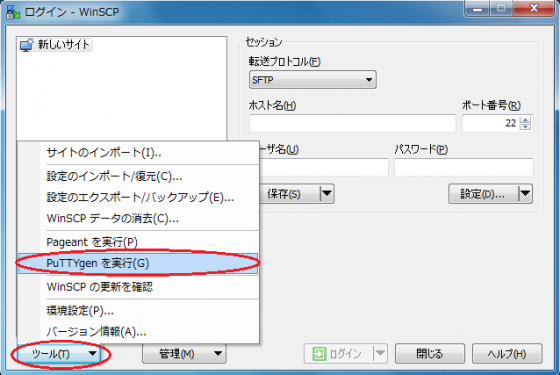

(2) PuTTY Key Generatorメニュー[Conversions]→[Import Key]を順に選択します。

(3)前述『2.1.1.1 事前準備(秘密鍵・公開鍵の作成と登録)』の手順で作成した秘密鍵を選択します。

※Windows環境の画面例

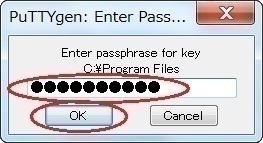

(4) 公開鍵・秘密鍵を作成した際のパスフレーズを入力し、[OK]ボタンをクリックします。

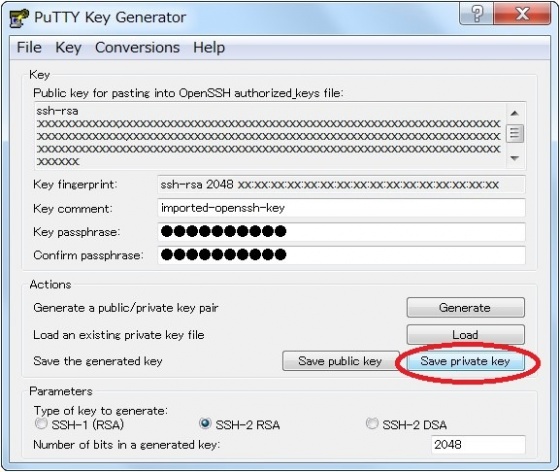

(5) [Save private key]ボタンをクリックします(変換した鍵が保存されます)。

▲このページの先頭へ

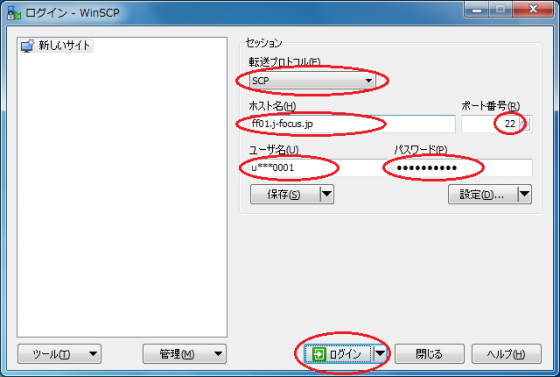

②SCPによるファイル転送(WinSCP使用)

前述の手順『①事前準備(秘密鍵の変換)』でPuTTY形式に変換した秘密鍵を使用します。

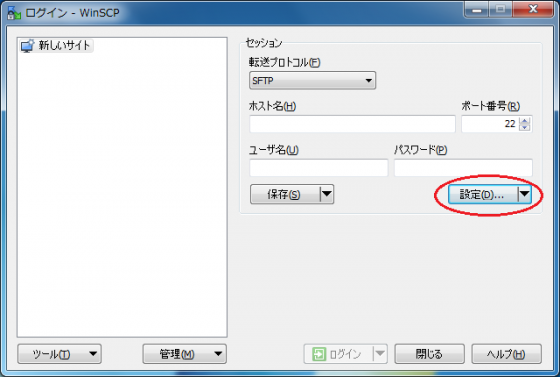

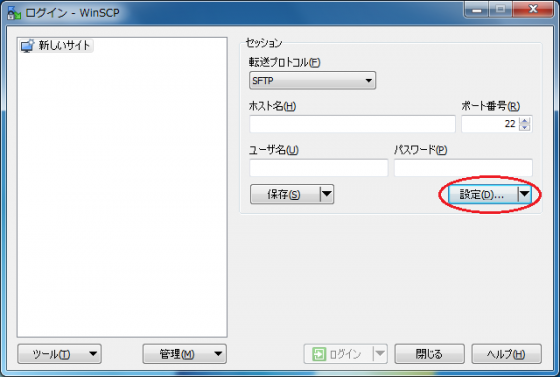

(1)スタートメニュー[すべてのプログラム]→[WinSCP]を順に選択します。

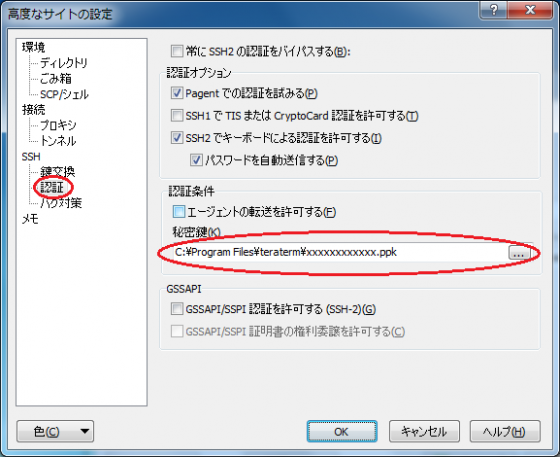

(2)『ログイン - WinSCP』画面で[設定]ボタンをクリックします。

(3)『高度なサイトの設定』画面で[SSH]→[認証]を順に選択し、以下の指定を行ないます。

|

・秘密鍵 |

PuTTY形式に変換した秘密鍵(∼.ppk) |

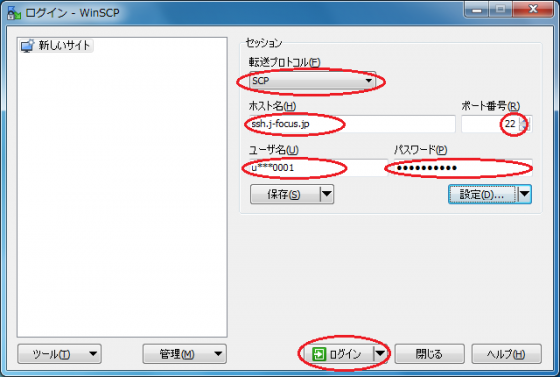

(4)『ログイン - WinSCP』画面に戻り以下の指定を行い、[ログイン]ボタンをクリックします。

|

・プロトコル |

SFTPまたはSCP |

|

・ホスト名/TD> |

ssh.j-focus.jp |

|

・ポート番号 |

22 |

|

・ユーザ名 |

アカウント名(「u」+“課題名”+数字4桁) |

|

・パスワード |

公開鍵・秘密鍵を作成した際のパスフレーズ |

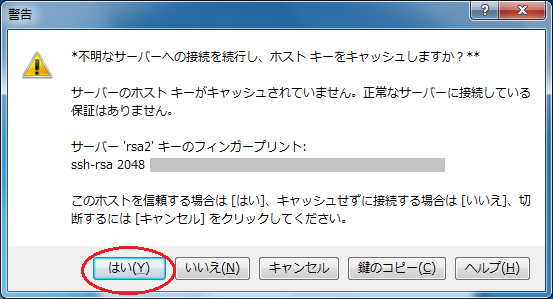

(3) 『警告』画面が表示された場合は内容を確認し、[はい]ボタンをクリックします。

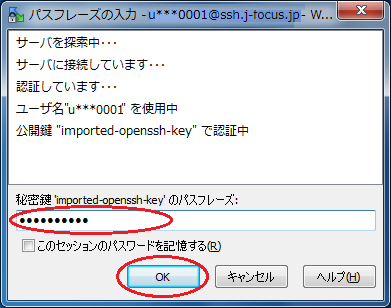

(4) 公開鍵・秘密鍵を作成した際のパスフレーズを入力し、[OK]ボタンをクリックします。

(5) 以下のような画面が表示され、お手元のマシンとログインサーバ間でファイル転送が出来るようになります。

▲このページの先頭へ

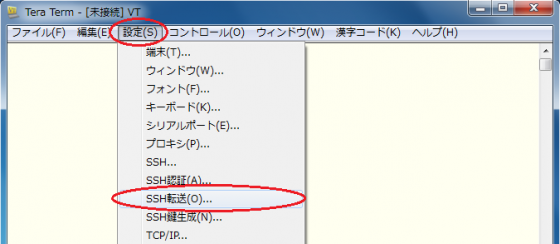

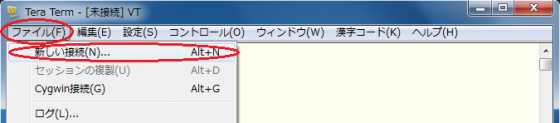

2.1.1.5.X Window Systemを利用するアプリケーションの使用方法(Windows環境)

(1) お手元のマシン(localhost)にCygwin/X 、Xming等のXサーバソフトウェアをあらかじめインストールしておき、お手元のマシン(localhost)でXサーバを起動します。

(2) スタートメニュー[すべてのプログラム]→[Tera Term]を順に選択します。

(3) Tera Term『新しい接続』画面で[キャンセル]ボタンをクリックします。(『新しい接続』画面を閉じます。)

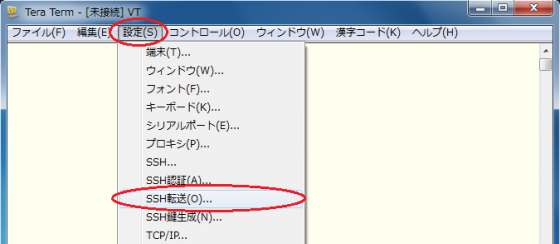

(4) Tera Termメニュー[設定]→[SSH転送]を選択します。

(5) [リモートの(X)アプリケーションをローカルのXサーバに表示する]にチェックを入れ、[OK]をクリックします。

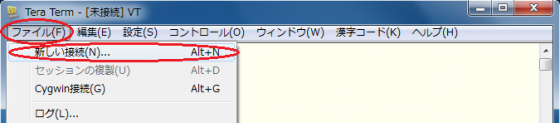

(6) Tera Termメニュー[ファイル]→[新しい接続]を順にクリックします。

(『新しい接続』画面を開きます。)

(7) ログインサーバにSSH接続します。(参照:『2.1.1.2 ログインサーバへのSSH接続』)

(8) ログインサーバから共用フロントエンドサーバ(ff01またはff02)にssh接続する際に、

-X (大文字エックス)オプションを付けます。

(9) 以上で、X Window Systemを利用するアプリケーションをお手元のマシンで利用出来るようになります。

▲このページの先頭へ

2.1.1.6.インターネットからのSSH多段接続によるログイン方法

前述2.1.1ではお手元のマシン(localhost)からログインサーバに接続し、そこから共用フロントエンドサーバに接続する方法を示しました。本節では、SSH多段接続によりlocalhostから直接フロントエンドサーバにログインする方法について示します。

・proxy設定によるSSH多段接続の設定方法

cygwin(Windows環境), MacOS X, Linux等のlocalhostで、$HOME/.ssh/config ファイルを以下のように設定します。ログインする共用フロントエンドサーバはff01.j-focus.jp、アカウント名はuser0001の場合の設定例になります。

【$HOME/.ssh/config 設定例】

Host FocusLogin #

HostName ssh.j-focus.jp # フロントエンドサーバの設定

User user0001 # アカウント名

Port 22 # ポート番号

IdentityFile ~/id_rsa # 秘密鍵の保管場所

Host ff01Focus

HostName ff01.j-focus.jp # ホストの指定

User user0001 #

ProxyCommand ssh FocusLogin nc %h %p #

|

configファイルでの設定終了後、フロントエンドへの接続を実行します。

【多段SSH接続実行例】

[localhost] $ ssh ff01Focus

Enter passphrase for key '~/id_rsa': ←公開鍵・秘密鍵のパスフレーズ

user0001@ff01's password: ←サーバログイン用のアカウントパスワードを入力

Last login: Wed Aug 29 14:05:10 2013 from login2.j-focus.jp

[user0001@ff01 ~]$ hostname

ff01.p

[user0001@ff01 ~]$

|

コマンドを使ってlocalhostから直接フロントエンドサーバへファイルのコピーを行うことも可能です。

【多段SSH接続を使ったscp実行例】

|

[local host] $ scp testfile ff01Focus:~ ←testfileをff01のホームにコピー Enter passphrase for key '~/id_rsa': ←公開鍵・秘密鍵のパスフレーズ user0001@ff01's password: ←サーバログイン用のアカウントパスワードを入力 testfile 100% 217 0.2KB/s 00:00 [localhost] $ |

▲このページの先頭へ

・Tera Termマクロ を使ったSSH多段接続の設定方法

Tera Term マクロを使い、ログインサーバへのSSH接続を自動化します。

(1) テキストエディタを使ってマクロを作成します。

以下では「FOCUS_FF.ttl」という名前でファイルを作成しています。

(接尾語は「.ttl」にしてください。)

LOGPATH = 'C:\<ログを保存したいパス>'

HOSTNAME1 = 'ssh.j-focus.jp'

HOSTNAME2 = 'ff.j-focus.jp'

USERNAME = 'アカウント名'

KEYFILE = 'C:\<事前準備で作成した秘密鍵の保管場所>\id_rsa'

COMMAND = HOSTNAME1

strconcat COMMAND ':22 /ssh /auth=publickey /user='

strconcat COMMAND USERNAME

strconcat COMMAND ' /keyfile='

strconcat COMMAND KEYFILE

strconcat COMMAND ' /ask4passwd'

connect COMMAND

LOGFILE = LOGPATH

strconcat LOGFILE HOSTNAME1

getdate datestr "%Y%m%d-%H%M%S"

strconcat LOGFILE '-'

strconcat LOGFILE datestr

strconcat LOGFILE '.log'

logopen LOGFILE 0 0 1 1 1

remote_prompt = '$'

wait remote_prompt

COMMAND = 'ssh '

strconcat COMMAND username

strconcat COMMAND '@'

strconcat COMMAND hostname2

sendln COMMAND

|

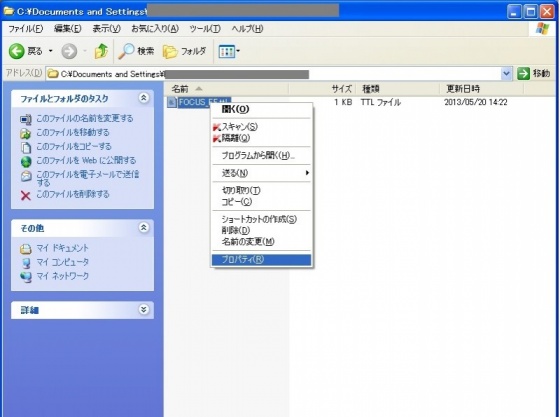

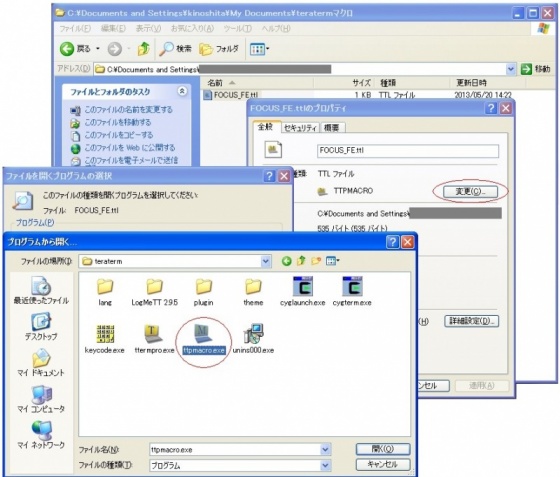

(2) エクスプローラを開き、該当ファイル(例「FOCUS_FF.ttl」)を右クリックし[プロパティ]を選択します。

(3)[ファイルの種類]→[変更]→[このファイルの種類を開くプログラムを選択]→[ttpmacro.exe]を選択します。

(4) 接尾語「.ttl」をもつファイル(例「FOCUS_FF.ttl」)をダブルクリックするとTera Termが起動します。

(5)「SSH認証」画面でパスワードを入力し、[OK]ボタンをクリックします。

(6) 以上の手順でフロントエンドサーバにログインできます。(「アカウント名@ff」コマンドは自動的に入力されます。)

▲このページの先頭へ

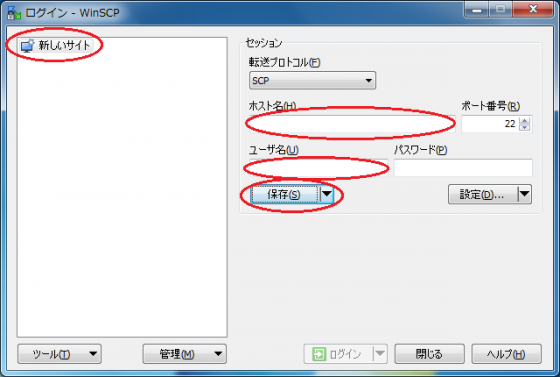

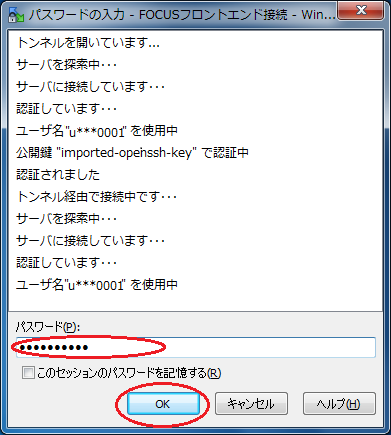

・SCPによるファイル転送(インターネットからのSSH多段接続)

ここでは前述の『2.1.1.4. SCPファイル転送』①事前準備で変換した秘密鍵を使用します。

(1) スタートメニュー[すべてのプログラム]→[WinSCP] を順に選択します。

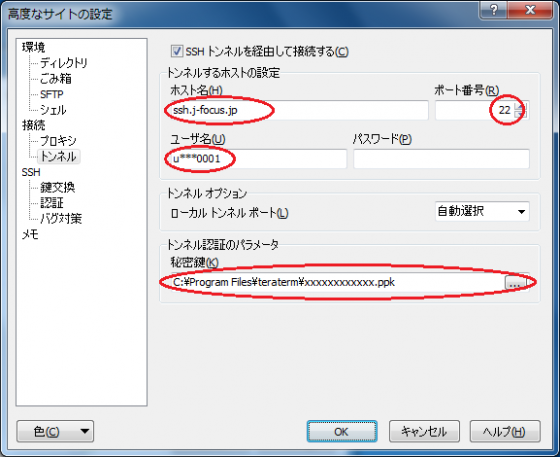

(2)『ログイン - WinSCP』画面で「設定」ボタンをクリックします。

(3)[接続]→[トンネル]を順に選択し、以下の指定を行います。

|

・SSHトンネルを経由して接続 |

チェックを入れる |

|

・ホスト名 |

ssh.j-focus.jp |

|

・ポート番号 |

22 |

|

・ユーザ名 |

アカウント名(「u」+“課題名”+数字4桁) |

|

・秘密鍵 |

WinSCP用に変換したPuTTY形式の秘密鍵を指定

(鍵の変換方法は『2.1.1.4. SCPファイル転送』①事前準備を参照) |

(4) 「新しいサイト」を選択し、以下を指定し、[保存]ボタンをクリックします。

|

・ホスト名 |

ff01またはff02 |

|

・ユーザ名 |

アカウント名(「u」+“課題名”+数字4桁) |

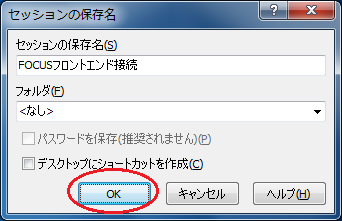

(5) 『セッションの保存名』画面で保存名(例:FOCUSフロントエンド接続)を入力し、[OK]ボタンをクリックします。

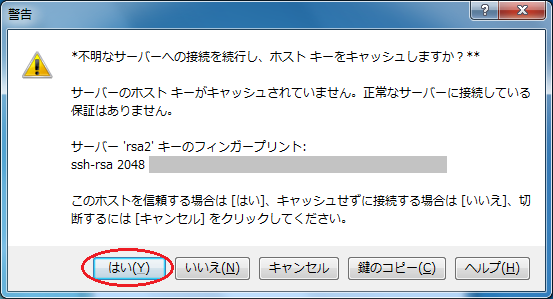

(6) 『警告』画面(初回アクセス時のみ表示されます)が表示されたら、内容を確認したうえで、[はい]ボタンをクリックします。

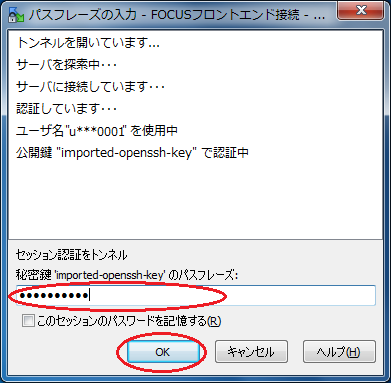

(7) 『パスフレーズの入力』画面で公開鍵・秘密鍵のパスフレーズを入力し、[OK]ボタンをクリックします。

(8)アカウントのパスワードを入力します。

(9) 以上でお手元のマシン(localhost)とフロントエンドサーバ間でファイル転送が出来るようになります。

▲このページの先頭へ

2.1.2.インターネットからのSSL-VPN接続による利用方法

お手元のマシンがインターネットに対してSSL-VPN接続できる環境であれば、SSL-VPN接続でアクセスすることができます。また、ログインするときのホスト名、接続プロトコルは下表のとおりです。

|

システム名 |

ホスト名 |

接続プロトコル |

|

SSH |

telnet |

SCP |

FTP |

共用フロントエンドサーバ

(共用利用向け) |

ff01, ff02 |

○ |

× |

○ |

× |

専用フロントエンドサーバ

(占有利用向け) |

ft01, ・・・, ft04,

fm01, ・・・, fm08,

ff03, ff04 |

共用フロントエンドサーバの利用については 「2.1.1.3.共用フロントエンドサーバへの接続」に記載の 【共用フロントエンド利用についての注意点】をご確認ください。

▲このページの先頭へ

2.1.2.1.SSL-VPN接続によるログイン

SSL-VPN接続を使ってログインすることができます。

図2.1.2.1 SSH接続イメージ

お手元のマシン

(localhost) |

→ |

SSL-VPN接続

(インターネット) |

→ SSH接続 → |

共用フロントエンドサーバ

(ff01.j-focus.jp,ff02.j-focus.jp) |

手順は次のとおりです。

(1)SSL-VPN接続を開始します。接続方法は『SSL-VPN利用者マニュアル』(http://www.j-focus.jp/sslvpn/)を参照します。

(2)スタートメニュー[すべてのプログラム]→[Tera Term]→[Tera Term]を順に選択します。(Tera Termを起動します。)

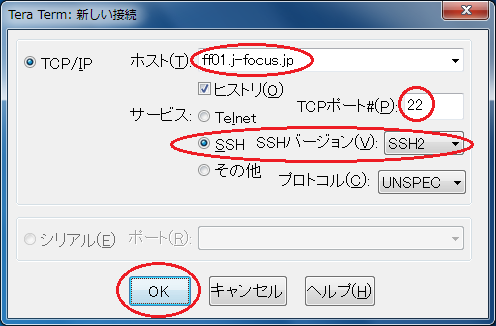

(3)Tera Term『新しい接続』画面で以下を指定し、[OK]ボタンをクリックします。

|

・ホスト名 |

ff01.j-focus.jp または ff02.j-focus.jp

(混雑しないように ff01 と ff02 を使いわけてください。) |

|

・サービス |

SSH |

|

・SSHバージョン |

SSH2 |

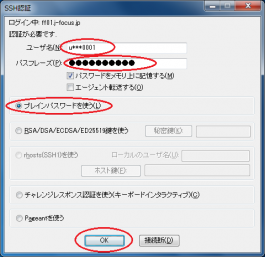

(4)『SSH認証』画面で以下を指定し、[OK]ボタンをクリックします。

|

・ユーザ名 |

アカウント名(「u」+“課題名”+数字4桁) |

|

・パスフレーズ |

パスワード |

|

・プレインテキストを使う |

チェックする |

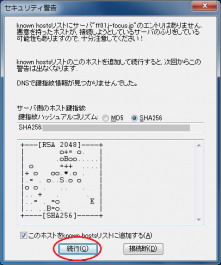

操作の途中で『セキュリティ警告』画面が表示された場合は[続行]ボタンをクリックして手順を続けます。

(5)以上の手順で共用フロントエンドサーバへのssh接続に成功すると、以下のような画面が表示されます。

▲このページの先頭へ

2.1.2.2.SSL-VPN接続によるSCPファイル転送(WinSCP使用)

SSL-VPN接続を使って、システムにSCPによるファイル転送を行います。

図2.1.2.2 SCPファイル転送

お手元のマシン

(localhost) |

→ |

SSL-VPN接続

(インターネット) |

→ SCPファイル転送 → |

共用フロントエンドサーバ

(ff01.j-focus.jp,ff02.j-focus.jp) |

手順は次のとおりです。

(1)SSL-VPN接続を開始します。接続方法は『SSL-VPN利用者マニュアル』(http://www.j-focus.jp/sslvpn/)を参照します。

(2)スタートメニュー[すべてのプログラム]→[WinSCP]→[WinSCP]を順に選択します。

(3)『WinSCPログイン』画面で以下の指定を行い、[ログイン]ボタンをクリックします。

|

・ファイルプロトコル |

SFTP |

|

・ホスト名 |

ff01.j-focus.jpまたはff02.j-focus.jp

(混雑しないように ff01 と ff02 を使いわけてください。) |

|

・ポート番号 |

22 |

|

・ユーザ名 |

アカウント名(「u」+“課題名”+数字4桁) |

|

・パスワード |

アカウントのパスワード |

(4) 下図のような画面でファイルを転送できるようになります。

▲このページの先頭へ

2.1.2.3.X Window Systemを利用するアプリケーションの使用

X Window Systemを利用するアプリケーションを使用する場合は事前に本手順を実行します。

(1)SSL-VPN接続を開始します。接続方法は『SSL-VPN利用者マニュアル』(http://www.j-focus.jp/sslvpn/)を参照します。

(2) スタートメニュー[すべてのプログラム]→[Cygwin-X]→[XWin Server]を順に選択します。

(3) スタートメニュー[すべてのプログラム]→[Tera Term]を順に選択します。

(4) Tera Term『新しい接続の設定』画面で、[キャンセル]ボタンをクリックします。

(5) Tera Termメニュー[設定]→[SSH転送]を順に選択します。

(6)『SSHポート転送』画面で、[リモートの(x)アプリケーションをローカルのXサーバに表示する]にチェックを入れ、[OK]ボタンをクリックします。

(7) Tera Termメニュー[ファイル]→[新しい接続]を順に選択します。

(8)前述の手順『2.1.1.2. ログインサーバへのSSH接続』、『2.1.1.3. 共用フロントエンドサーバへの接続』を使って、共用フロントエンドサーバにSSH接続を行い、続けてアプリケーション固有の操作を行うことで、X Window Systemを利用するアプリケーションを使用できます。

▲このページの先頭へ

2.1.3.高度計算科学研究支援センター内でのログイン方法

前述『2.1.2. インターネットからのSSL-VPN接続による利用方法』の各小節(2)以降の手順を使って、センター内からFOCUSスパコンシステムにログインできます。なお、講習用端末のハードディスクは、再起動すると初期化されますのでご注意ください。

▲このページの先頭へ