FOCUSスパコンご利用前FAQ(PDF版)

1.FOCUSスパコンシステムの概要

目次 (1. FOCUSスパコンシステムの概要)

1. FOCUSスパコンシステムの概要

1.1. システム構成

1.1.1. システム概念図

1.1.2. システム構成要素の特徴

1.2. ハードウェア構成

1.2.1. サーバ

1.3. ソフトウェア構成

1.3.1. オペレーティングシステム(OS)

1.3.2. ソフトウェア

1.3.3. アプリケーション

1.3.3.1. ライセンスが必要なアプリケーション(商用・有償)

1.3.3.2. フリーソフトウェア

1.3.3.3. アプリケーションに関するサポート

1.4. 製品マニュアル

1.5. ディレクトリ構成

1.5.1. 共用フロントエンドサーバ

1.5.2. 演算ノード

1.5.3. クォータ確認コマンド(追加ストレージ/home2)

1. FOCUSスパコンシステムの概要

1.1. システム構成

1.1.1. システム概念図

1.1.2. システム構成要素の特徴

産業利用加速用計算機システムを構成する要素について、特徴は以下の通りです。

FOCUSスパコンシステムを構成する要素について、特徴は以下の通りです。

・ファイアウォール

インターネットからの不正アクセスを防ぎます。各種ポートを塞いだり一方通行にしたり等のアクセス制御を行います。

・ウェブサーバシステム

FOCUSスパコンシステムの利用に関する情報を提供します。運用情報や予約状況等を表示します。

・ログインサーバシステム

インターネットからのSSHプロトコルを使用したログイン接続、ファイル転送の中継を行います。この計算機に一旦ログインしてから再度、フロントエンドサーバシステムにSSHでログイン、ファイル転送を行います。

・フロントエンドサーバシステム

FOCUSスパコンシステムを利用するための拠点となります。プロジェクト毎の専用のファイルシステムがマウントされ、利用者がログインし、プログラムの開発、ジョブ管理システムの利用、小規模な解析・デバッグ、小規模なプリポスト処理等を行います。

・Aシステム ノード間高並列演算指向

ノード内12コアを利用した共有メモリ並列から、Infiniband-QDR(40Gbit/s)で接続されたノード間分散メモリ並列、それらを組み合わせたハイブリッド並列に利用頂けます。

・Bシステム プリポスト・大容量メモリ処理用

大容量共有メモリ(512GB)を備え、入力データを作成したり、計算した結果をディスク上から大規模共有メモリに読込んで高速にポスト処理を行ったりするためのシステムです。ノード内に16コアを備えております。

・Cシステム ノード内並列専用

通信ネットワークを除いて性能はAシステムと同等です。ノード間はGigabit Ethernetで接続されています。このためノード内並列に利用頂けます。

・Dシステム ノード内並列/ノード間高並列演算兼用

ノード内20コアを利用した共有メモリ並列から、Infiniband-FDR(56Gbit/s)で接続されたノード間分散メモリ並列、それらを組み合わせたハイブリッド並列に利用頂けます。

・Eシステム コプロセッサ搭載システム

インテル製 「Xeon Phi 5110P」(1基あたり60コア)をノード1台あたり4基(60×4=240コア)、合計192基を搭載しております。ノード内20コアを利用した共有メモリ並列から、Infiniband-FDR(56Gbit/s)で接続されたノード間分散メモリ並列、それらを組み合わせたハイブリッド並列に利用頂けます。

・Gシステム コプロセッサ搭載システム(デバッグキュー用)

インテル製 「Xeon Phi 5110P」(1基あたり60コア)をノード1台あたり1基搭載しております。ノード内12コアを利用した共有メモリ並列から、Gigabit Ethernetで接続されたノード間分散メモリ並列、それらを組み合わせたハイブリッド並列に利用頂けます。

・NASストレージシステム ホーム領域(/home1)

物理容量は360TBです。

/home1としてマウントされております。ユーザーのホーム領域として課題毎に200GBの利用が可能です。通信帯域は全体で500MB/sです。通信帯域はFOCUSスパコン全ユーザにて共有しているため、I/O性能は自身も含めた全ユーザのI/O状況に依存

します。

・大容量分散高速ストレージシステム ホーム兼ワーク領域(/home2)

物理容量は1640TBです。/home2としてマウントされています。ユーザのホーム兼ワーク領域となり、利用には追加契約が必要となります。通信帯域は全体で11GB/s、プロセスあたり最大1GB/sです。分散ファイルシステムであり、上記NASストレージシステムと比べて22倍の通信帯域となっておりますので、大規模並列計算の複数プロセスによるI/Oに適しております。

1.2. ハードウェア構成

1.2.1. サーバ

・Aシステム

| ハードウェア | 富士通 BX922 S2 |

| CPU | Intel Xeon L5640(2.26GHz) ×2CPU(計12コア)/ノード |

| メモリ | 48 GB/ノード |

| インタフェース | Infiniband-QDR(40Gbps)×1/ノード |

・Bシステム

| ハードウェア | 富士通製RX600 S5 |

| CPU | Intel Xeon X7520(1.86GHz) ×4CPU(計16コア)/ノード |

| メモリ | 512 GB/ノード |

| インタフェース | Infiniband-QDR(40Gbps)×1/ノード |

・Cシステム

| ハードウェア | 富士通製CX122S1 |

| CPU | Intel Xeon L5640(2.26GHz)×2CPU(計12コア)/ノード |

| メモリ | 48 GB/ノード |

・Dシステム

| ハードウェア | Cray H2312WFFKR (HPC専用 2Uラックマウント型 ブレードサーバ) |

| CPU | Intel Xeon E5-2670 v2 (2.5GHz) ×2CPU(計20コア)/ノード |

| メモリ | 64 GB/ノード |

| インターフェース | Infiniband-FDR(56Gbps)×1/ノード |

・Eシステム

| ハードウェア | Cray GreenBlade GB824X (HPC専用 ブレード型サーバ) |

| CPU | Intel Xeon E5-2670 v2 (2.5GHz) ×2CPU(計20コア)/ノード |

| コプロセッサ | Intel Xeon Phi 5110P ×4基(計240コア)/ノード |

| メモリ | 128 GB/ノード |

| インターフェース | Infiniband-FDR(56Gbps)×1/ノード |

・Gシステム

| ハードウェア | NEC Express5800/HR120a-1 |

| CPU | Intel Xeon E5-2640 (2.5GHz) ×2CPU(計12コア)/ノード |

| コプロセッサ | Intel Xeon Phi 5110P ×1基(計 60コア)/ノード |

| メモリ | 64 GB/ノード |

・共用フロントエンドサーバ

| ハードウェア | Intel R2308GZ4GC (HPC専用 2Uラックマウント型サーバ) |

| CPU | Intel Xeon E5-2680 v2 (2.8GHz) ×2CPU(計20コア)/ノード |

| コプロセッサ | Intel Xeon Phi 5110P x 1基(計60コア)/ノード |

| メモリ | 64 GB/ノード |

・インターネット高速転送サーバ

IBM Sytem x3550M4で構成され、ハードウェアをログインサーバと共用します。

・ログインサーバ

IBM System x3550M4 2ノードによる構成です。うち一台は、インターネット高速転送サーバとハードウェアを共用します。

1.3. ソフトウェア構成

1.3.1. オペレーティングシステム(OS)

各システムで採用するオペレーティングシステム(OS)を示します。

表 1.3.1 オペレーティングシステム(OS)

| システム名 | オペレーティングシステム(OS) |

| ログインサーバ | CentOS 6.3(64bit版) |

| フロントエンドサーバ | Red Hat Enterprise Linux 6.4(64bit版) |

| 演算ノード | CentOS 6.4(64bit版) |

1.3.2. ソフトウェア

FOCUSスパコンシステムで利用可能な主なソフトウェアの一覧を示します。

表 1.3.2 ソフトウェア一覧

| ソフトウェア | フロントエンドサーバ | 演算ノード |

| ジョブスケジューラ | ||

| Slurm Workload Manager 2.6.2 | ○ | ○ |

| 開発環境(コンパイラ) | ||

| インテル(R) Cluster Studio XE 2012 | ○ | ○ |

| インテル(R) Cluster Studio XE 2013 | ○ | ○ |

| インテル(R) Cluster Studio XE 2013 SP1 | ○ | ○ |

| インテル(R) Cluster Studio XE 2013 SP1 Updae 2 | ○ | ○ |

| インテル(R) Parallel Studio XE 2015 Cluster Edition Update 1 | ○ | ○ |

| GNU 4.4.7 | ○ | ○ |

| GNU 4.8.2 | ○ | ○ |

| ソフトウェア | ||

| Java SDK 1.7.0_45 | ○ | ○ |

| Emacs 23.1.1 | ○ | - |

| vim 7.2 | ○ | - |

| OpenMPI 1.4.2 | ○ | ○ |

| OpenMPI 1.6.5 | ○ | ○ |

| MPICH2 1.4.1p1 | ○ | ○ |

| OpenMX 3.7.6 | ○ | ○ |

| GAMESS 201310 | ○ | ○ |

| ABINIT-MP 4.1 | ○ | ○ |

| ABINIT-MP 6.0 | ○ | ○ |

| ABINIT-MP 7.0 | ○ | ○ |

| NAMD 2.9 | ○ | ○ |

| GROMACS 4.6.5 | ○ | ○ |

| LAMMPS 28Jun14 | ○ | ○ |

| Quantum ESPRESSO 5.0.2 | ○ | ○ |

| OpenFOAM 2.2.2 | ○ | ○ |

| OpenFOAM 2.3.0 | ○ | ○ |

| ParaView 4.0.1 | ○ | ○ |

| gnuplot 4.6.4 | ○ | ○ |

| Octave 3.6.4 | ○ | ○ |

| Pov-Ray 3.6.1 | ○ | ○ |

| R 3.0.2 | ○ | ○ |

| GLview 20131211 | ○ | ○ |

| AutoDock Vina 1.1.2 | ○ | ○ |

| NTChem 2013 4.0 | ○ | ○ |

| GNU Scientific Library 1.16 | ○ | ○ |

| cmake 2.8.12 | ○ | ○ |

| Python 2.7.6 | ○ | ○ |

| Python 3.3.3 | ○ | ○ |

1.3.3. アプリケーション

/home1/share/にインストールしたアプリケーション、数値計算ライブラリ等はご自由に利用ください。FOCUSスパコン上で動作検証済みの商用・有償アプリケーション(Gaussian、MIZHO/BioStation、ParallelCONFLEX 以外)は、ソフトウェアベンダーからライセンスを取得して頂きまして利用頂けます。その他フリーソフト等、各利用者がホームディレクトリ配下に独自にインストールしたものが利用可能です。

1.3.3.1.ライセンスが必要なアプリケーション(商用・有償)

a)コンパイラ

Intelコンパイラは、導入済みのライセンスがありますので、使用していただくことができます。 (ただしまれに同時にご使用の方が多いタイミングで、導入しておりますライセンス数を越えてしまい、ご使用のためのライセンスがありませんというエラーが出ることがありますが、そのような場合はしばらく時間を置いてご利用下さい。)

b)Gaussian、MIZUHO/BioStation, ParallelCONFLEX

Gaussian、MIZUHO/BioStation や ParallelCONFLEX をFOCUSスパコンで利用する場合は、ライセンスを準備する必要はありませんが、演算ノードの利用料とは別にノード時間に応じて利用料がかかります。これらアプリケーションの利用を希望するユーザは、OKBiz( https://secure.okbiz.okwave.jp/focus/ )より利用希望する旨連絡してください。

c)上記以外の商用・有償ソフトウェア

上記以外の商用・有償ソフトウェアをFOCUSスパコンで利用する場合は、各アプリケーションのベンダーに問い合わせて下さい。(FOCUSスパコンに未導入の商用ソフトウェアを利用されたい場合は、各ソフトウェアベンダーにFOCUSスパコンで使用したいとご相談下さい。)

1.3.3.2.フリーソフトウェア

/home1/shareにインストールされているアプリケーション、ライブラリ等は自由に使っていただくことができます。しかしながら当該アプリケーションのご利用にあたってはFOCUSによるサポートはありません。

利用者あるいはグループとしてFOCUSスパコンに未導入のフリーソフトウェアを利用されたい場合は、各アカウントのホームディレクトリやグループ共用のホーム領域(/home1/グループ名/share)に自由にインストールして利用して頂いてかまいません。基本的にFOCUSからのサポートはありません。

1.3.3.3.アプリケーションに関するサポート

FOCUSスパコンに導入した商用ソフトウェアのサポートは各ソフトウェアベンダーが行っており、以下のサポートサービスが提供されております。

FOCUSスパコンに導入された商用ソフトウェアのサポートは各ソフトウェアベンダーが行います。 ソフトウェアベンダーのサポート以外に、現在、以下のサポートサービスが提供されております。

・OpenFOAM利用サポートサービス:(株)CAEソリューションズ

・Gaussian/GaussView/GAMESS/AMBER/CONFLEX利用サポートサービス:コンフレックス(株)

その他、ISV事業者により様々なサポートが準備されており、ご紹介が可能です。紹介をご希望の方はOKBiz(https://secure.OKBiz.okwave.jp/focus/)でお問合せ下さい。

1.4. 製品マニュアル

センターのネットワーク内で、製品マニュアルを閲覧できます。下記のURLからアクセスしてご覧ください。

〔URL〕http://fl01.j-focus.jp/ablog/manual/

表 1.4 マニュアル一覧

| 関連製品名 | マニュアル名称 | 形式 | 和 | 英 |

| インテル® Cluster Studio XE 2013 | インテル Cluster Studio XE リリースノート | ○ | ||

| インテル Visual Fortran Composer XE 2013 入門ガイド | ○ | |||

| インテル Parallel Studio XE 2013 入門ガイド | ○ | |||

| インテル® Cluster Studio XE 関連ドキュメント | コンパイラー OpenMP 入門 | ○ | ||

| インテル CilkPlus ユーザーズガイド | ○ | |||

| OpenMP 3.0 C/C++構文の概要 | ○ | |||

| インテル OpenMP 互換ライブラリー 利用ガイド | ○ | |||

| コンパイラー最適化 クイック・リファレンス・ガイド | ○ | |||

| SP1Update1リリースノート | ○ | |||

| インテル® C++ Composer XE 2013 Linux 版 | インテル C/C++ コンパイラー OpenMP 活用ガイド | ○ | ||

| 日本語ユーザー・リファレンス・ガイド | ○ | |||

| インテル® Fortran Composer XE 2013 Linux 版 | インテル Fortran コンパイラー OpenMP 活用ガイド | ○ | ||

| 日本語ユーザー・リファレンス・ガイド | ○ | |||

| インテル Fortran ライブラリー・リファレンス | ○ | |||

| インテル® MPI ライブラリー | Intel MPI 入門ガイド | ○ | ||

| インテル® Inspector XE | チュートリアル-メモリーエラーを検出する(C++) | ○ | ||

| チュートリアル-メモリーエラーを検出する(Fortran) | ○ | |||

| チュートリアル-スレッド化エラーを検出する(C++) | ○ | |||

| チュートリアル-スレッド化エラーを検出する(Fortran) | ○ | |||

| インテル® MKL | MKL ユーザーズガイド | ○ | ||

| 入門チュートリアル C++ 言語向け | ○ | |||

| 入門チュートリアル Fortran 言語向け | ○ | |||

| インテル® VTune Amplifier XE | チュートリアル-hotspotを見つける(C++) | ○ | ||

| チュートリアル-hotspotを見つける(Fortran) | ○ | |||

| チュートリアル-ハードウェアの問題を特定する | ○ | |||

| チュートリアル-ロックと待機を解析する | ○ | |||

| SLURM 2.6.2 | SLURM 2.6.2 Documentation | HTML | ○ | |

| Gaussian09 | Gaussian 09 User's Reference | HTML | ○ | |

| IOps Reference | HTML | ○ | ||

| 電子構造論による化学の探究 | 製本 | ○ | ||

| Linda | Using Gaussian 09 with Linda | HTML | ○ | |

| GaussView | GaussView 5 Reference | ○ |

1.5. ディレクトリ構成

ご利用の形態やソフトウェア、ジョブの特性によってディレクトリ(ストレージシステム)を使い分けていただくようお願い致します。

1.5.1.共用フロントエンドサーバ

共用フロントエンドサーバのディレクトリ構成は下表のとおりです。

表1.5.1 ディレクトリ構成(共用フロントエンドサーバ)

| ディレクトリパス | 利用目的 |

| /home1/グループ名/アカウント名 | ホームディレクトリ |

| /home1/グループ名 | グループ共用のホーム領域。容量は課題(グループ)あたり200GB |

| /home1/グループ名/share | グループで共用するソフトウェアを格納するための領域 |

| /home2/グループ名 | グループ共用の追加ストレージ領域 |

|

/home1/グループ名/アカウント名/skeed または /home2/グループ名/アカウント名/skeed |

インターネット高速転送システムでデータ授受を行う場合に使用。専用ソフトウェアでは”/”と表示される。 |

| /home1/share | システム全体で共用するソフトウェアを格納 |

※グループ名は「g」+“課題ID”、アカウント名は「u」+“課題名”+数字4桁です。

(参考)

/home1 NASストレージシステム(書込み性能 全体で500MB/s)

/home2 分散ファイルシステム(書込み性能 全体で11GB/s、1プロセスあたり最大1GB/s)

1.5.2.演算ノード

演算ノードのディレクトリ構成は下表のとおりです。

表1.5.2 ディレクトリ構成(演算ノード)

| ディレクトリパス | 利用目的 |

| /work | スクラッチディレクトリ(演算ノードのローカルディスク) |

※演算ノードにログインすることはありません。

(参考)/workの書込み性能は各システムにより異なります。

実測値は付録A「スパコンシステム各種サーバ及びファイルシステム構成図」をご参照ください。

1.5.3.クォータ確認コマンド(追加ストレージ/home2)

/home1の容量は課題(グループ)あたり200GBですが、追加ストレージ領域(/home2)の容量についてはご契約内容により異なります。現在の容量(上限値)を確認するには次のlfsコマンドを使用します。

〔コマンド〕

| lfs quota -g グループ名 /home2 |

〔実行結果〕

|

% lfs quota -g gXXX /home2 Disk quotas for group gXXX (gid XXXX): Filesystem kbytes quota limit grace files quota limit grace /home2 4 1059061760 1059061760 - 1 0 0 - |

※quota列に上限値(kbytes)が表示されます。

5.2.専用クライアント(SkeedSilverBullet GUI)の使用方法

目次 (5.2.専用クライアント(SkeedSilverBullet GUI)の使用方法)

5.2. 専用クライアント(SkeedSilverBullet GUI)の使用方法

5.2.1. クライアントのインストール

5.2.2. クライアントの環境設定

5.2.3. クライアントの起動

5.2.4. ファイルのアップロード

5.2.5. ファイルのダウンロード

5.2.専用クライアント(SkeedSilverBullet GUI)の使用方法

5.2.1.クライアントのインストール

(1)次のいずれかの方法でインストールプログラムを入手します。

(方法1)

次の手順を参照し、お手元のマシンでSCP転送の画面を起動します。

・『2.1.1.4.SCPファイル転送』

・『2.1.2.2.SSL-VPN接続によるSCPファイル転送(WinSCP使用)』

フロントエンドサーバの /home1/share/skeed ディレクトリから、次のファイルをお手元のマシンにダウンロードします。

| Windowsの場合 | SetupSkeedSilverBulletClient_2.3.12.2.exe |

| MacOS Xの場合 |

SetupSkeedSilverBullet_2.3.12.2.dmg ※本手順では、MacOS Xのアプリケーションフォルダに保存することを前提に説明します。 |

(方法2)

SSL-VPN接続でセンター内にあるインストールプログラムをダウンロードできます。下記のURLからアクセスしてください。

〔URL〕http://fl01.j-focus.jp/ablog/client_software/ssb.html

(2)プログラムを起動します。

| Windowsの場合 | [SetupSkeedSilverBulletClient_2.3.12.2.exe]をダブルクリックします。 |

| MacOS Xの場合 |

[SetupSkeedSilverBullet_2.3.12.2.dmg]をダブルクリックし、 展開された[SkeedSilverBullet]をダブルクリックします。 |

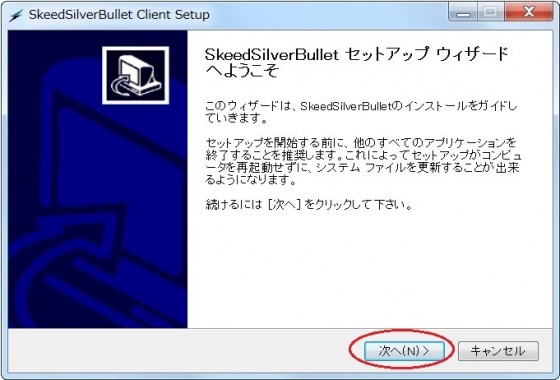

(3)【Windowsのみ】『SkeedSilverBullet Client Setup』画面で[次へ]ボタンをクリックします。

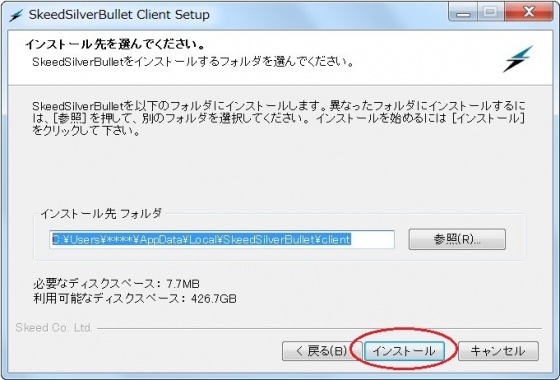

(4)【Windowsのみ】インストール先を確認(または指定)し、[インストール]ボタンをクリックします。

※初期値は C:\Users\<アカウント名>\AppData\Local\SkeedSilverBullet\client です。

変更する場合は、参照ボタンからインストール先を指定後、「インストール」をクリックします。

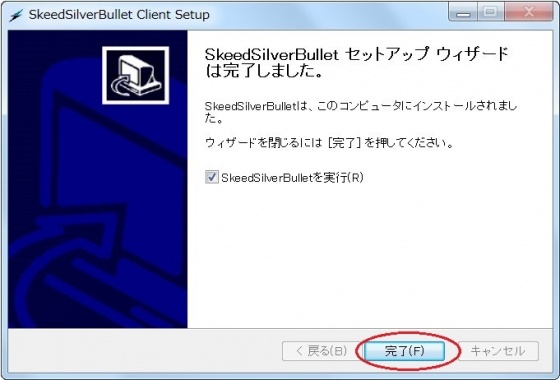

(5)【Windowsのみ】「完了しました」が表示されたことを確認し、[完了]ボタンをクリックします。

※「SkeedSilverBulletを実行」にチェックが入っている場合はSkeedSilverBullet GUIクライアントが起動されます。

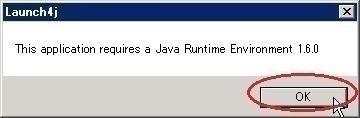

※JAVAのインストール

お使いのPCにJAVAがインストールされていない場合には以下の様なダイアログが表示されます。

手順にしたがってJAVAをインストールします。

5.2.2.クライアントの環境設定

(1)SkeedSilverBulletを起動します。

| Windowsの場合 | [スタート]→[すべてのプログラム]→[Skeed]→[SilverBulletClient]→[SkeedSilverBulletClient]を順に選択します。 |

| MacOS Xの場合 | メニュー[移動]→[アプリケーション]→[SkeedSilverBullet]を順に選択します。 |

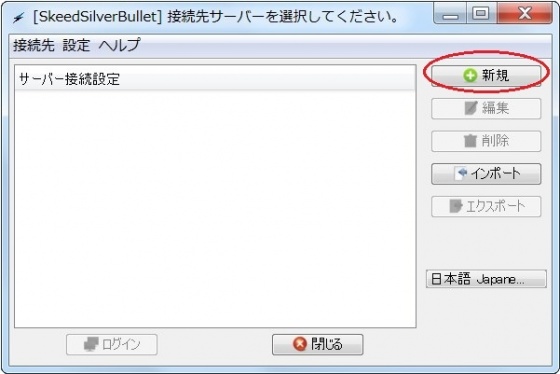

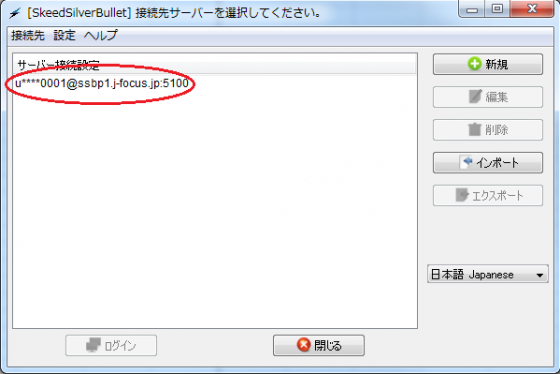

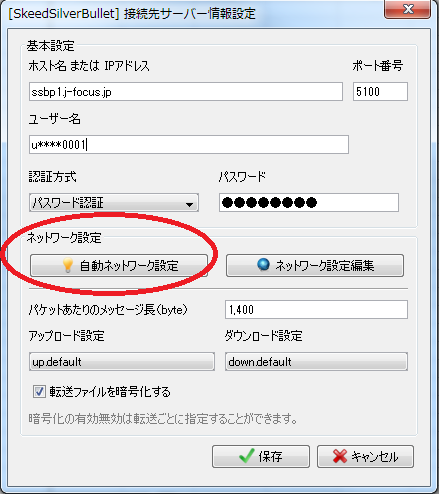

(2)『接続先サーバーを選択してください。』画面で、[新規]ボタンをクリックします。

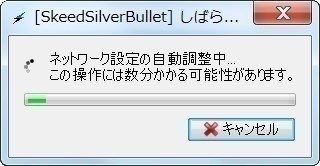

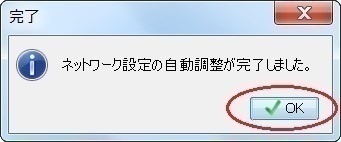

(3)次の項目を入力し、画面中央部にある[自動ネットワーク設定]ボタンをクリックします。

接続先サーバは2つありますので、どちらかに接続してください。

| ホスト名 | ssbp1.j-focus.jp または ssbp2.j-focus.jp |

| ポート番号 | 5100 |

| ユーザー名 | アカウント名(「u」+“課題名”+数字4桁) |

| 認証方式 | パスワード認証 |

| パスワード | アカウントのパスワード(変更は『2.2.1.パスワードの変更(センター外)』を参照) |

(4)『完了』画面が表示されることを確認し、[OK]ボタンをクリックします。

(5)画面下部の[保存]ボタンをクリックします。

(これにより接続先サーバの情報が登録され、一覧画面での選択が可能になります。)

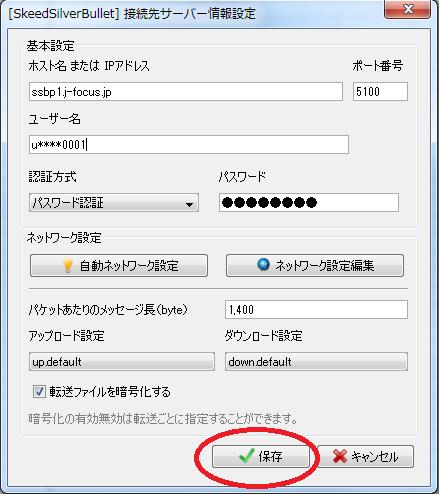

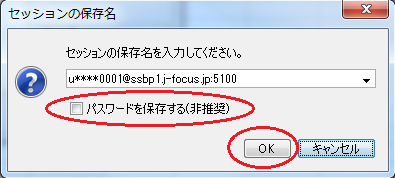

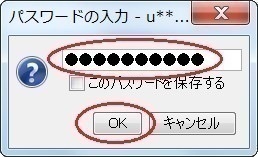

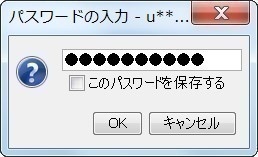

(6)「パスワードを保存する」のチェックを外し、[OK]ボタンをクリックします。

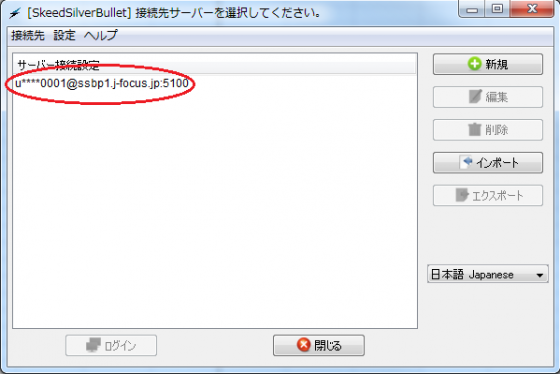

(7)『サーバー接続設定』欄に、登録した接続先が表示されることを確認します。

(8)登録した接続先をダブルクリックします。

(9)パスワードを入力し、[OK]ボタンをクリックします。

5.2.3.クライアントの起動

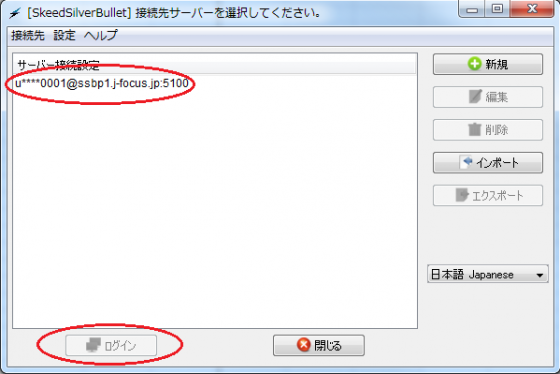

(1)SkeedSilverBulletを起動します。

| Windowsの場合 | [スタート]→[すべてのプログラム]→[Skeed]→[SilverBulletClient]→[SkeedSilverBulletClient]を順に選択します。 |

| MacOS Xの場合 | メニュー[移動]→[アプリケーション]→[SkeedSilverBullet]を順に選択します。 |

(2)登録した接続先を選択し、[ログイン]ボタンをクリックします。

(3)パスワードを入力し、[OK]ボタンをクリックします。

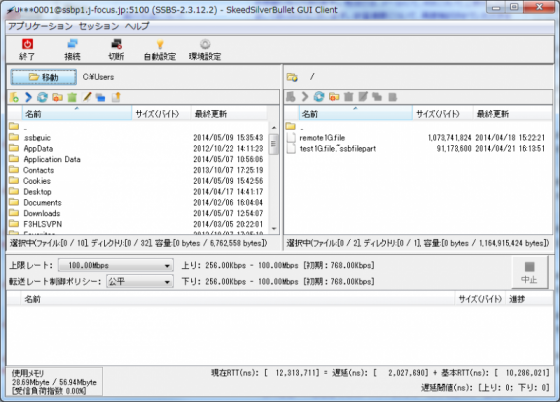

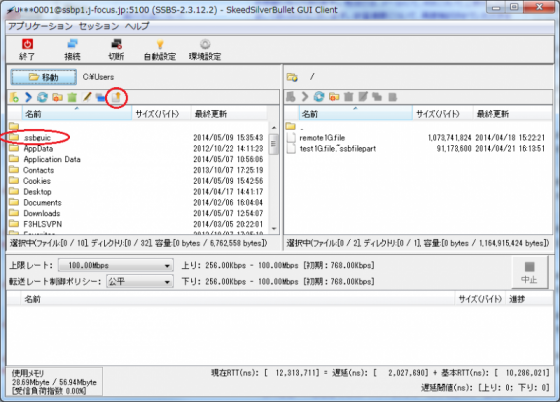

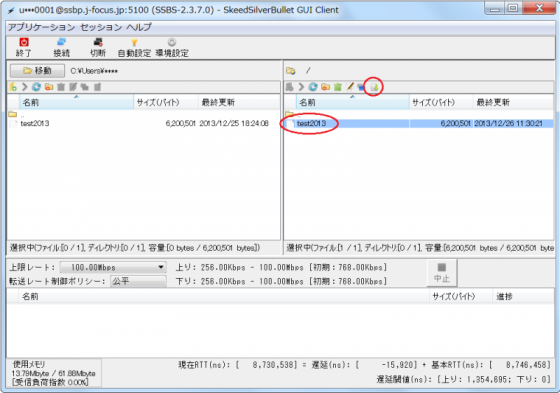

(4)正常に接続が完了したら、以下のような画面が表示されます。

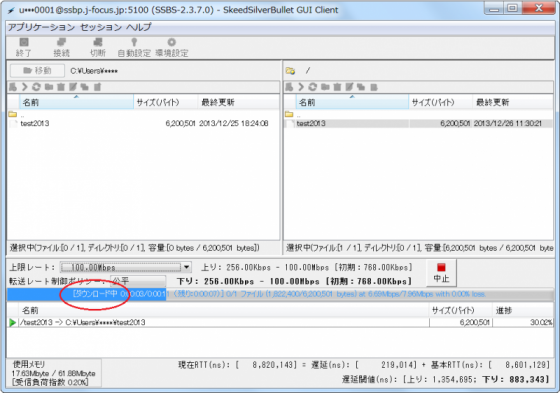

5.2.4.ファイルのアップロード

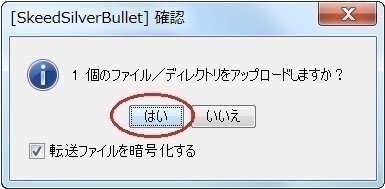

(1)アップロードするファイルをクリックし、[アップロード]アイコン をクリックします。

(2)アップロードの確認画面で、[はい]ボタンをクリックします。

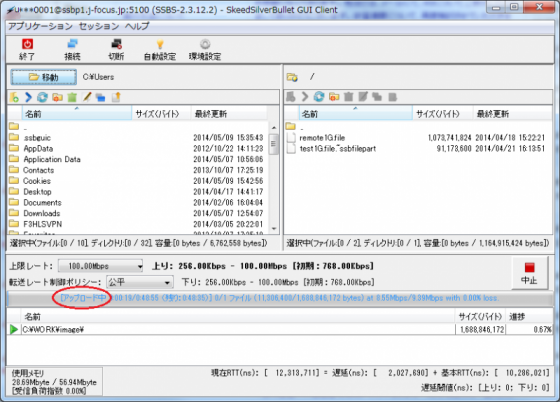

※アップロード中の画面イメージ(“アップロード中”という文字とともに進捗がバーで表示される。)

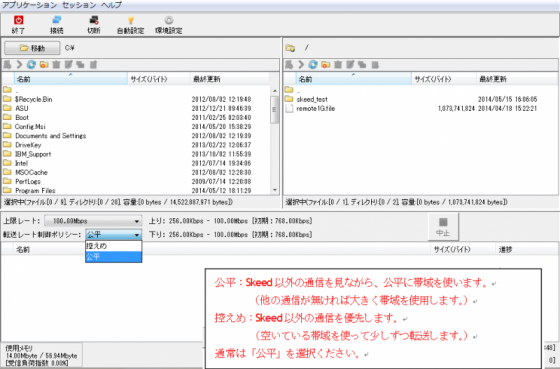

(3)【任意】転送中に「転送レート制御ポリシー」を変更します。

ポリシーは、「控えめ」、「公平」 の中から選択できます。

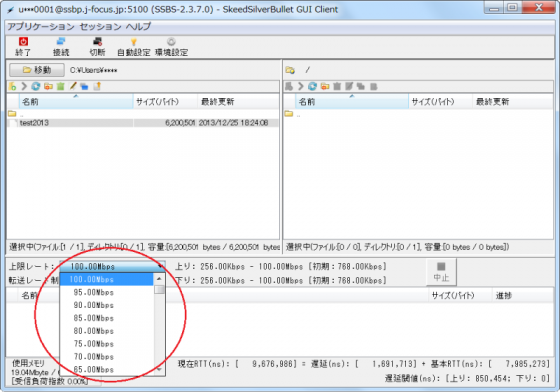

(4)【任意】転送中に「上限レート」を変更します。

指定した転送帯域を超えないように設定することが可能です。

5.2.5.ファイルのダウンロード

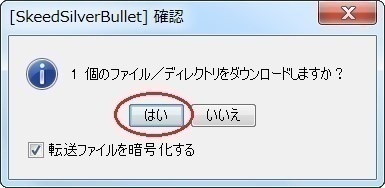

(1)ダウンロードするファイルをクリックし、[ダウンロード]アイコン をクリックします。

(2)ダウンロード確認画面で、[はい]ボタンをクリックします。

※アップロード同様、上限レート、転送レート制御ポリシーを変更できます。

※ダウンロード中の画面イメージ(“ダウンロード中”という文字とともに進捗がバーで表示される。)

4.4.ジョブ投入スクリプトの作成

目次 (4.4.ジョブ投入スクリプトの作成)

4.4. ジョブ投入スクリプトの作成

4.4.1. 処理方法の指定

4.4.2. sbatchオプション

4.4.3. 環境変数

4.4.4. 逐次ジョブを実行する場合

4.4.5. スレッド並列ジョブを実行する場合

4.4.6. MPIプログラム(openMPI)を実行する場合

4.4.7. MPIプログラム(Intel MPI)を実行する場合

4.4.8. MPIプログラム(mpich2)を実行する場合

4.4. ジョブ投入スクリプトの作成

ジョブ投入のためのジョブ投入スクリプトを作成します。

4.4.1. 処理方法の指定

ジョブ投入スクリプトの中で“#SBATCH”で始まる行にsbatch オプションを記述すると、処理方法を指定することができます。

4.4.2. sbatch オプション

主なsbatch オプションを次に示します。

表 4.4.2 sbatch オプション

| ジョブ投入スクリプトのディレクティブ | #SBATCH |

|---|---|

| キュー(パーティション)指定 | -p [queue] |

| 実行ノード数(並列数の指定) | -N [minnodes[-maxnodes]], --nodes=[minnodes[-maxnodes]] |

| CPU 数の指定(プロセス数の指定) | -n [number], --ntasks=[number] |

| 実行時間の上限指定(wall time) |

-t [minutes], --time=[minutes] |

| 出力ファイル指定 | -o [filename], --output=[filename] |

| エラー出力指定 | -e [filename], --error=[filename] |

| 出力・エラー出力の総合出力 | (-e 指定無しで-o を使用) |

| イベント通知 |

--mail-type=[type] ※type はBEGIN, END, FAIL, REQUEUE, ALL のいずれか |

| メールアドレス指定 | --mail-user=[address] |

| ジョブ再投入 | --requeue または --no-requeue(未指定時は--no-requeue) |

| 実行ディレクトリ指定 | --workdir=[dir_name] |

| メモリサイズ指定 | --mem=[mem][M|G|T] OR --mem-per-cpu=[mem][M|G|T] |

| ノード当たりのタスク数指定 | --tasks-per-node=[count] |

| タスク当たりのCPU数指定 | --cpus-per-task=[count] |

| 依存ジョブ |

--dependency=[type:job_id]

type には次の依存タイプを指定できます。 |

| ジョブのプロジェクト化 | --wckey=[name] |

| ジョブ実行ホストの詳細 | --nodelist=[nodes] AND/OR --exclude=[nodes] |

| アレイジョブ | --array=[array_spec] |

| 開始時間指定 | --begin=YYYY-MM-DD[THH:MM[:SS]] |

4.4.3. 環境変数

sbatch コマンド実行時、ジョブ実行時に環境変数が設定されます。設定される主な環境変数を示します。

表 4.4.3 環境変数

| 環境変数 | 内容 |

|---|---|

|

SLURM_JOB_CPUS_PER_NODE |

ジョブ実行に使用されるホストとプロセス数のリスト |

| SLURM_JOB_ID | ジョブID |

| SLURM_JOB_NAME | fjsub –N やsbatch -J で指定したジョブ名。ジョブ名を指定していない場合は、実際に指定されたコマンド列が格納されます。 |

| SLURM_JOB_NODELIST | ジョブが実行されるホスト名のリスト |

| SLURM_NTASKS | sbatch –n(または ––ntasks)で指定したプロセス数 |

| SLURM_SUBMIT_DIR | ジョブ が投入されたカレントディレクトリ |

4.4.4. 逐次ジョブを実行する場合

逐次(並列計算を行わない方式)で実行する時に作成するジョブ投入スクリプトの例を示します。

|

#!/bin/bash #SBATCH -p d024h ・・・・・・・・・・ (1) #SBATCH -n 1 ・・・・・・・・・・ (2) #SBATCH -J test_serial ・・・・・・・・・・ (3) #SBATCH -o stdout.%J ・・・・・・・・・・ (4) #SBATCH -e stderr.%J ・・・・・・・・・・ (5) ./a.out ・・・・・・・・・・ (6) |

(1) パーティション名(キュー名)を指定します。

(2) ジョブで使用するプロセス数(-n もしくは--ntasks=<number>)を指定します。

逐次ジョブの場合、プロセス数は1 となりますので、指定値は“-n 1”を指定します。

(3) ジョブ名を指定します。

(4) 標準出力ファイルを指定します。%J はジョブID に変換されます。

(5) 標準エラー出力ファイルを指定します。%J はジョブID に変換されます。

(6) プログラム(a.out)を実行します。

4.4.5. スレッド並列ジョブを実行する場合

スレッド並列(単体ノードで並列計算を行う方式)でジョブを実行する時に作成するジョブ投入スクリプトの例を示します。

|

#!/bin/bash #SBATCH -p d024h ・・・・・・・・・・ (1) #SBATCH -n 1 ・・・・・・・・・・ (2) #SBATCH -c 20 ・・・・・・・・・・ (3) #SBATCH -J test_openmp ・・・・・・・・・・ (4) #SBATCH -o stdout.%J ・・・・・・・・・・ (5) #SBATCH -e stderr.%J ・・・・・・・・・・ (6) export OMP_NUM_THREADS=${SLURM_NTASKS} ・・・・・・・・・・ (7) ./a.out ・・・・・・・・・・ (8) RETCODE=$? exit ${RETCODE} ・・・・・・・・・・ (9) |

(1) パーティション名(キュー名)を指定します。

(2) ジョブで使用するプロセス数(-n もしくは--ntasks=<number>)を指定します。

上記の例では、1 プロセスで実行するために-n 1 を指定しています。

(3) ジョブで使用するCPU数(-cもしくは—cpus-per-task=<number>)を指定します。

上記の例では、20スレッドで実行するために-c 20を指定しています。

(4) ジョブ名を指定します。

(5) 標準出力ファイルを指定します。%J はジョブID に変換されます。

(6) 標準エラー出力ファイルを指定します。%J はジョブID に変換されます。

(7) 環境変数 OMP_NUM_THREADS にスレッド数を指定します。

(8) プログラム(a.out)を実行します。

(9) プログラムの戻り値をSLURM に戻します。

4.4.6. MPI プログラム(openMPI)を実行する場合

プロセス並列(複数のノードで並列計算を行う方式)のジョブをOpenMPI で実行する時に作成するジョブ投入スクリプトの例を示します。

下記スクリプトでは、Dシステムにて2ノード(1ノードあたり2プロセス)のジョブが生成されます。

|

#!/bin/bash #SBATCH -p d024h ・・・・・・・・・・ (1) #SBATCH -n 40 ・・・・・・・・・・ (2) #SBATCH -J test_openmpi ・・・・・・・・・・ (3) #SBATCH -o stdout.%J.log ・・・・・・・・・・ (4) #SBATCH -e stderr.%J.log ・・・・・・・・・・ (5) module load gnu/openmpi165 ・・・・・・・・・・ (6) mpirun -np ${SLURM_NTASKS} ./a.out ・・・・・・・・・・ (7) RETCODE=$? exit ${RETCODE} ・・・・・・・・・・ (8) |

(1) パーティション名(キュー名)を指定します。

(2) ジョブで使用するプロセス数(-n もしくは--ntasks=<number>)を指定します。

(3) ジョブ名を指定します。

(4) 標準出力ファイルを指定します。%J はジョブID に変換されます。

(5) 標準エラー出力ファイルを指定します。%J はジョブID に変換されます。

(6) MPI 環境変数をセットします。

(7) プログラム(a.out)を実行します。

(8) プログラムの戻り値をSLURM に戻します。

上記(6)については、次の実行方法があります。

|

標準GNU コンパイラー (GNU 4.4.7) |

OpenMPI | module load gnu/openmpi165 |

| MPICH2 | module load gnu/mpich2141p1 | |

| IntelMPI | module load impi411 | |

| GNU4.8.2 コンパイラー | OpenMPI |

module load PrgEnv-gnu482 module load gnu/openmpi165 |

| MPICH2 |

module load PrgEnv-gnu482 module load gnu/mpich2141p1 |

|

| IntelMPI |

module load PrgEnv-gnu482 module load impi411 |

|

| Intel コンパイラー | OpenMPI |

module load PrgEnv-intel module load intel/openmpi165 |

| MPICH2 |

module load PrgEnv-intel module load intel/mpich2141p1 |

|

| IntelMPI |

module load PrgEnv-intel module load impi411 |

4.4.7. MPI プログラム(Intel MPI)を実行する場合

プロセス並列(複数のノードで並列計算を行う方式)のジョブをIntelMPI で実行する時に作成するジョブ投入スクリプトの例を示します。

|

#!/bin/bash #SBATCH -p d024h #SBATCH -n 40 #SBATCH -J test_intelmpi #SBATCH -o stdout.%J.log #SBATCH -e stderr.%J.log module load PrgEnv-intel module load impi411 NODEFILE=`generate_pbs_nodefile` mpirun -np ${SLURM_NTASKS} ./a.out |

(注) インテルコンパイラで作成された実行ファイルを実行する場合、ジョブ投入スクリプト内に

|

module load PrgEnv-intel module load impi411 |

の行を記載する必要があります。

4.4.8. MPI プログラム(mpich2)を実行する場合

プロセス並列(複数のノードで並列計算を行う方式)のジョブをGNU コンパイラで作成したMPI プログラム(mpich2)で実行する時に作成するジョブ投入スクリプトの例を示します。

|

#!/bin/bash #SBATCH -p d024h #SBATCH -n 40 #SBATCH -J test_gnu #SBATCH -o stdout.%J.log #SBATCH -e stderr.%J.log module load PrgEnv-gnu482 module load gnu/mpich2141p1 NODEFILE=`generate_pbs_nodefile` mpirun -np ${SLURM_NTASKS} ./a.out |

(注) GNU コンパイラが用意するmpich2 環境を利用し、GNU コンパイラで作成された実行ファイルを実行する場合、ジョブ投入スクリプト内に

|

module load PrgEnv-gnu482 module load gnu/mpich2141p1 |

の行を記載する必要があります。

2.6.moduleコマンド

目次 (2.6.moduleコマンド)

2.6.moduleコマンド

FOCUSスパコンでは、様々なプログラムの実行環境の設定にmoduleコマンドを用います。

(1) 対応している環境の一覧表示

| $ module avail |

【実行例】

|

$ module avail --------------------------- /home1/share/modulefiles --------------------------- MIZUHO_ABINIT-MP3.01 PrgEnv-pgi-13.10-0 impi502 MIZUHO_ABINIT-MP3.0_FOCUS PrgEnv-pgi-14.2-0 intel/mpich2141p1 PrgEnv-gnu482 PrgEnv-pgi-716 intel/openmpi165 PrgEnv-intel PrgEnv-pgi-725 pgi/mpich2141p1 PrgEnv-intel-12.1.0.233 PrgEnv-pgi-806 pgi/mpich2141p1_DE PrgEnv-intel-13.0.1.117 PrgEnv-pgi-904 pgi/openmpi165 PrgEnv-intel-14.0.0.080 cmake2812 pgi/openmpi165_DE PrgEnv-intel-14.0.2.144 conflex python/2.7.6 PrgEnv-intel-15.0.1.133 gnu/mpich2141p1 python/3.3.3 PrgEnv-pgi gnu/openmpi142 share PrgEnv-pgi-109 gnu/openmpi165 slurm PrgEnv-pgi-1110 impi410 PrgEnv-pgi-1210 impi411 |

(2) 環境設定の読み込み

| $ module load モジュール名 |

【実行例】

| $ module load PrgEnv-intel |

(3) 読み込んだ環境設定の表示

| $ module list |

【実行例】

|

$ module list Currently Loaded Modulefiles: 1) PrgEnv-intel 2) impi411 |

(4) 環境設定の解除

| $ module unload モジュール名 |

【実行例】

| $ module unload PrgEnv-intel |

【次回1/20開催】HPCIアクセスポイント神戸利用講習会

平成25年度 HPCIアクセスポイント神戸利用講習会を

下記の内容にて催しますのでご案内いたします。

日 時:

・【終了】 4月 8日(火) 14時~15時

・【終了】 4月22日(火) 16時~17時

・【終了】 5月 7日(水) 16時~17時

・【終了】 5月20日(火) 16時~17時

・【終了】 6月 3日(火) 16時~17時

・【終了】 6月17日(火) 16時~17時

・【終了】 7月 8日(火) 16時~17時

・【終了】 7月22日(火) 16時~17時

・【終了】 8月 5日(火) 16時~17時

・【終了】 8月19日(火) 16時~17時

・【終了】 9月 9日(火) 16時~17時

・【終了】 9月24日(水) 16時~17時

・【終了】10月 7日(火) 16時~17時

・【終了】10月21日(火) 16時~17時

・【終了】11月 4日(火) 16時~17時

・【終了】11月18日(火) 16時~17時

・ 【終了】12月 9日(火) 16時~17時

・ 【終了】12月22日(月) 16時~17時

・ 【受付終了】1月 6日(火) 16時~17時

・【受付中】 1月20日(火) 16時~17時

・ 2月 3日(火) 16時~17時

・ 2月17日(火) 16時~17時

・ 3月 4日(水) 16時~17時

・ 3月17日(火) 16時~17時

場 所: 高度計算科学研究支援センター(計算科学センタービル)

http://www.j-focus.or.jp/access.html

参加費: 無料

概要:

HPCIアクセスポイント神戸利用講習会では、スーパーコンピュータ「京」及び 「京」以外のHPCIの産業利用拠点として整備されたHPCIアク セスポイント神戸 の概要紹介と利用手続きの流れ、利用方法について簡潔にご紹介致します。 1回の講習会での最大定員は10名とし、可能な限り5名以下の受講者を対象と した手厚い講習を心がけております。「京」やHPCIのアカウントをお持ちの方に は2室の作業用個室で実際に10ギガビットイーサネット経由で毎秒1ギガバイトの データ転送を実現するにはどう言った点に注意すれば良いか等を実習しながら学 んでいただきます。 HPCIアクセスポイント神戸利用講習会プログラム 1)HPCIアクセスポイント神戸の概要 1.1 設置目的 1.2 紹介・申請・予約状況Webページ 1.3 ネットワークと機器概要 1.4 データ転送性能例 2)利用の流れ 2.1 利用者登録申請 2.2 利用許可申請 3)ネットワークと機器と利用方法 3.1 機器の特徴 3.2 ネットワークの種類と特徴 3.3 機器とデータ転送方法 3.4 プリポストソフトウェアの起動方法 3.4.1 AVS/Express PCE 3.4.2 Pointwise 3.4.3 FieldView 3.4.3 Ensight DR 4)質疑応答

申し込み方法:

参加ご希望の方は、 request[at]j-focus.or.jp ([at]を@に変更して下さい) まで、

件名を 「参加希望 HPCIアクセスポイント神戸利用講習会」 として、

以下の内容をご通知下さい。

================================

フリガナ :

お名前 :

ご所属 :

ご連絡先 :

参加希望講習会開催日 :

================================

参加申し込み締め切り:

講習会開催2業務日前AM10:00

4.2.ジョブの実行方法(SLURMコマンド編)

目次 (4.2.ジョブの実行方法(SLURMコマンド編))

4.2. ジョブの実行方法(SLURMコマンド編)

4.2.1. ジョブ投入コマンド(sbatch)

4.2.2. ジョブ情報表示コマンド(squeue)

4.2.3. ジョブのキャンセルコマンド(scancel)

4.2.4. ジョブステータス情報表示コマンド(sstat)

4.2.ジョブの実行方法(SLURMコマンド編)

ジョブを実行するには、フロントエンドサーバからコマンドを実行します。

ジョブ管理のためのコマンドは次のとおりです。

表4.2 ジョブ管理コマンド一覧(SLURMコマンド編)

| コマンド | コマンド用途 | 手順 |

| sinfo -s | キュー(パーティション)の情報を表示する | 4.1.2.キュー情報の確認方法 |

| squeues | キューのノード実行状況を表示する | |

| freenodes | 空ノード数を表示する | 4.1.3. 利用可能なノード数の確認方法 |

| sbatch | ジョブを投入する | 4.2.1.ジョブ投入コマンド(sbatch) |

| squeue | ジョブの状態を表示する | 4.2.2.ジョブ情報表示コマンド(squeue) |

| scancel | ジョブをキャンセルする | 4.2.3.ジョブのキャンセルマンド(scancel) |

4.2.1.ジョブ投入コマンド(sbatch)

ジョブを実行するために、ジョブ投入スクリプトを事前に作成します。sbatchコマンドにジョブ投入スクリプトを指定することで、ジョブがキューイングされ実行されます。

【sbatchコマンドの書式】

| $ sbatch ジョブ投入スクリプト |

注)bsubと異なり、リダイレクトではなく、引数でジョブ投入スクリプトを渡します。

【sbatchコマンドの例(スクリプトファイルがrun.shの場合)】

| $ sbatch run.sh |

ジョブ投入コマンド(sbatch)について、以下に主なオプションを示します。

表 4.2.1 sbatchオプション

| オプション | 概要 |

| sbatch -J "sample job name" | ジョブに任意のジョブ名をつけます。 |

| sbatch -p キュー名 | 指定したキュー名のキュー(パーティション)にジョブを投入します。 |

| sbatch -N ノード数 | ノード数を指定します。 |

| sbatch -n プロセス数 | ジョブ全体でのプロセス数を指定します。 |

| sbatch -o ./out_%j.log(※) | out_ジョブIDという名前のファイルに標準出力を出力します。-eオプションが指定されていない場合は、標準エラー出力もこのファイルに出力されます。 |

| sbatch -e ./err_%j.log(※) |

err_ジョブIDという名前のファイルに標準エラー出力を出力します。 ※シンボル「%j」はジョブIDに置換されます。 |

4.2.2.ジョブ情報表示コマンド(squeue)

ジョブの各種情報を表示するときは、squeueコマンドを実行します。

| $ squeue |

注)他の利用者の情報は表示されません。

【squeueコマンド例】

|

$ squeue JOBID PARTITION NAME USER ST TIME NODES NODELIST(REASON) xxxx d024h testrun u***0001 R 4:58 60 d[007-066] xxxx debug6m testrun u***0001 CG 0:39 1 f001 |

<出力説明>

| JOBID |

ジョブに割り当てられたジョブIDが表示されます。 ジョブの削除(scancel)などで指定する識別子となります。 |

| PARTITION | ジョブを投入したキューの名前を表示します。 |

| NAME | ジョブ名(未指定の場合はコマンド文字列)を表示します。 |

| USER | ジョブ投入リクエスト(ジョブ)の実行者を表示します。 |

| ST | ジョブの状態を表示します。主なジョブの状態を以下の表に示します。 |

| TIME | ジョブの実行時間(形式:days-hh:mm:ss) |

| NODES | ジョブ実行に使用されるノード数 |

| NODELIST(REASON) |

ジョブが実行されるホスト名のリスト (ジョブ状態に対する理由があれば表示されます) ジョブ状態がPD(PENDING)の場合のREASONを下記に示します。 (Resources) リソースが利用可能になるのを待っています。 (Priority) パーティション内の優先度の高いジョブが完了するのを待っています。 (Dependency) このジョブが依存する他のジョブが完了するのを待っています。 (InvalidQOS) Resources と同義です。 |

表 4.2.2 ジョブ状態(squeueコマンド-STフィールド)

| 状態 | 説明 |

| CA (CANCELLED) | ジョブが明示的にユーザまたはシステム管理者によってキャンセルされました。 |

| CD (COMPLETED) | ジョブは、すべてのノード上のすべてのプロセスを終了しました。 |

| CF (CONFIGURING) | ジョブは、資源が割り当てられた後、資源が使える状態になるのを待っている状態です。 |

| CG (COMPLETING) | ジョブは、終了手続きの過程にあります。 |

| F (FAILED) | ジョブは、ゼロ以外の終了コードまたはその他の障害状態で終了しました。 |

| NF (NODE_FAIL) | ジョブは、割り当てられたノードのいずれかの故障のために終了しました。 |

| PD (PENDING) | ジョブは、資源の割り当てを待っています。保留中です。 |

| PR (PREEMPTED) | ジョブが中断のために終了しました。 |

| R (RUNNING) | ジョブは、現在実行中です。 |

| S (SUSPENDED) | ジョブは、資源の割り当てを持っています(実行が中断されています)。 |

| TO (TIMEOUT) | ジョブは、その制限時間に達して終了しました。 |

4.2.3.ジョブのキャンセルマンド(scancel)

ジョブをキャンセルするにはscancelコマンドを用います。squeueコマンドなどで確認したジョブIDを指定します。scancelの後に、ジョブIDをスペース区切りで指定すると、複数のジョブを一度にキャンセルすることができます。

| $ scancel ジョブID ジョブID ジョブID |

4.2.4.ジョブステータス情報表示コマンド(sstat)

ジョブの各種情報(メモリ使用量やディスクI/O量など)を表示するときは、sstatコマンドを実行します。ジョブを実行中に実行する必要があります。

| $ sstat –j ジョブID[.ステップID] [-o 項目[,項目]] |

注)他の利用者の情報は表示されません。

ジョブステータス情報表示コマンド(sstat)について、以下に主なオプションを示します。

表 4.2.4 sstatオプション

| オプション | 概要 |

| -j ジョブID[.ステップID] |

ジョブIDを指定します。必須のオプションです。ステップIDは省略可能です。 ステップIDはsqueue -sコマンドで確認することができます。 ※逐次処理の場合はステップIDとして「batch」を指定します。 |

| –o 項目[,項目]... |

出力する項目をカンマ区切りで指定します。指定しない場合、全ての項目が表示されます。 一部、FOCUS環境では取得できない項目もあります。 |

| -e | -oオプションで指定できる項目を表示します。 |

【sstatコマンド例1】

|

$ sstat -j 45643 -o JobID,MaxVMSize,MaxRSS,MaxPages,MaxDiskRead,MaxDiskWrite JobID MaxVMSize MaxRSS MaxPages MaxDiskRead MaxDiskWrite ------------ ---------- ---------- -------- ------------ ------------ 45643.0 1332496K 39276K 293K 1M 0.29M |

【sstatコマンド例2】

|

$ sstat -j 45638.0 JobID MaxVMSize MaxVMSizeNode MaxVMSizeTask AveVMSize MaxRSS MaxRSSNode MaxRSSTask AveRSS MaxPages MaxPagesNode MaxPagesTask AvePages MinCPU MinCPUNode MinCPUTask AveCPU NTasks AveCPUFreq ReqCPUFreq ConsumedEnergy MaxDiskRead MaxDiskReadNode MaxDiskReadTask AveDiskRead MaxDiskWrite MaxDiskWriteNode MaxDiskWriteTask AveDiskWrite ------------ ---------- -------------- -------------- ---------- ---------- ---------- ---------- ---------- -------- ------------ -------------- ---------- ---------- ---------- ---------- ---------- -------- ---------- ---------- -------------- ------------ --------------- --------------- ------------ ------------ ---------------- ---------------- ------------ 45638.0 1579688K g002 1 912640K 38696K g002 1 26118K 279K g002 1 214K 00:00.000 g001 0 00:00.000 2 2.50G 0 0.96M g002 1 0.68M 0.02M g002 1 0.02M |

<出力説明>

| JOBID | ジョブに割り当てられたジョブIDが表示されます。 |

| MaxVMSize | ジョブの全てのタスクでの仮想メモリサイズの最大値です。 |

| MaxVMSizeNode | MaxVMSizeが発生しているノードです。 |

| MaxVMSizeTask | MaxVMSizeが発生しているタスクのIDです。 |

| AveVMSize | ジョブの全てのタスクでの仮想メモリサイズの平均値です。 |

| MaxRSS | ジョブの全てのタスクでの物理メモリ消費サイズの最大値です。 |

| MaxRSSNode | MaxRSSが発生しているノードです。 |

| MaxRSSTask | MaxRSSが発生しているタスクのIDです。 |

| AveRSS | ジョブの全てのタスクの物理メモリ消費サイズの平均値です。 |

| MaxPages | ジョブの全てのタスクでのページフォールト数の最大値です。 |

| MaxPagesNode | MaxPagesが発生しているノードです。 |

| MaxPagesTask | MaxPagesが発生しているタスクのIDです。 |

| AvePages | ジョブの全てのタスクでのページフォールト数の平均値です。 |

| MinCPU | ジョブの全てのタスクでのCPU時間の最小値です。 |

| MinCPUNode | MinCPUが発生しているノードです。 |

| MinCPUTask | MinCPUが発生しているタスクのIDです。 |

| AveCPU | ジョブの全てのタスクでのCPU時間の平均値です。 |

| NTasks | ジョブまたはステップの中でのタスクの合計数です。 |

| AveCPUFreq | ジョブの全てのタスクでの重み付けをしたCPU周波数の平均値(kHz)です。 |

| ReqCPUFreq | ステップに要求されたCPU周波数(kHz)です。 |

| ConsumedEnergy | ジョブの全てのタスクでの消費エネルギー(ジュール)です。 |

| MaxDiskRead | ジョブの全てのタスクでの読み込み量の最大値(bytes)です。 |

| MaxDiskReadNode | MaxDiskReadが発生しているノードです。 |

| MaxDiskReadTask | MaxDiskReadが発生しているタスクのIDです。 |

| AveDiskRead | ジョブの全てのタスクでの読み込み量の平均値(bytes)です。 |

| MaxDiskWrite | ジョブの全てのタスクでの書き込み量の最大値(bytes)です。 |

| MaxDiskWriteNode | MaxDiskWriteが発生しているノードです。 |

| MaxDiskWriteTask | MaxDiskWriteが発生しているタスクのIDです。 |

| AveDiskWrite | ジョブの全てのタスクでの書き込み量の平均値(bytes)です。 |

4.1.キュー

目次 (4.1.キュー)

4.1. キュー

4.1.1. キューの一覧

4.1.2. キュー情報の確認方法

4.1.3. 利用可能なノード数の確認方法

4.1.キュー

4.1.1.キューの一覧

フロントエンドサーバから演算ノードに対して、ジョブを投入できるキューの一覧を示します。

表4.1.1 キューの一覧

| キュー名 | 最大ジョブ数 | 最大ジョブ投入数 | 最長実行時間 | 最大ノード数(※) | ジョブあたり最大ノード数(※) | システム | 備考 |

| a024h | 未設定 | 無制限 | 24時間 | 224 | 224 | A | |

| a096h | 未設定 | 5/ユーザ | 96時間 | 100 | 100 | A | |

| b024h | 未設定 | 無制限 | 24時間 | 2 | 2 | B | |

| b096h | 未設定 | 5/ユーザ | 96時間 | 1 | 1 | B | |

| c024h | 未設定 | 無制限 | 24時間 | 22 | 22 | C | |

| c096h | 未設定 | 5/ユーザ | 96時間 | 11 | 11 | C | |

| d006h | 未設定 | 無制限 | 6時間 | 112 | 112 | D | |

| d012h | 未設定 | 無制限 | 12時間 | 112 | 112 | D | |

| d024h | 未設定 | 無制限 | 24時間 | 80 | 80 | D | |

| d072h | 未設定 | 5/ユーザ | 72時間 | 40 | 40 | D | |

| e024h | 未設定 | 無制限 | 24時間 | 48 | 16 | E | |

| e072h | 未設定 | 5/ユーザ | 72時間 | 24 | 8 | E | |

| debug6m | 未設定 | 5/ユーザ | 6分 | 4 | 2 | G | デフォルトキュー |

※最大ノード数は計算資源の予約状況により変動します。

(1)デフォルトキューは「debug6m」となります。ジョブ実行時にキュー名が省略された場合「debug6m」で実行されます。

(2)実際に本システムを利用する際には、sinfo -s コマンドで利用できるキュー名を確認して下さい。

(3)キューのノード実行状況を確認する際には、squeuesコマンドで確認して下さい。

4.1.2.キュー情報の確認方法

ジョブ投入先のキュー名を確認するには、sinfoコマンドを実行します。

| $ sinfo -s |

【実行例】

|

$ sinfo -s |

<出力説明>

| PARTITION | キュー名(パーティション名) |

| AVAIL | キューの状態(up or inact) |

| TIMELIMIT | 最大実行時間 |

| NODES(A/I/O/T) | ノードの状態(allocated/idle/other/total) |

| NODELIST | キュー(パーティション)に割り当てられたノード |

キューのノード実行状況を確認するには、squeuesコマンドを実行します。

注意:SLURMの標準コマンドのsqueueとは別コマンドです。

| $ squeues |

【実行例】

|

$ squeues |

<出力説明>

| QUEUE_NAME | キュー名(パーティション名) |

| TIMELIMIT | 最大実行時間 |

| STATUS | キューの状態(up or inact) |

| MAXNODES | 最大ノード数 |

| NNODES | 実行中及び実行待ちのジョブが要求しているノード数 |

| PEND | 実行待ちのジョブが要求しているノード数 |

| RUN | 実行中のノード数 |

4.1.3.利用可能なノード数の確認方法

空きノード数を確認するfreenodesというコマンドを用意しています。ジョブ投入のための空きノード数の確認の目安にご利用ください。

| $ freenodes |

【出力形式】

|

Number of free nodes in A sys. with FDR-IB connected is 空きノード数 / 提供最大ノード数. Number of free nodes in B sys. with FDR-IB connected is 空きノード数 / 提供最大ノード数. Number of free nodes in C sys. with GbE connected is 空きノード数 / 提供最大ノード数. Number of free nodes in D sys. with FDR-IB connected is 空きノード数 / 提供最大ノード数. Number of free nodes in E sys. with FDR-IB connected is 空きノード数 / 提供最大ノード数. Number of free nodes in G sys. with GbE connected is 空きノード数 / 提供最大ノード数. |

【実行例】

|

$ freenodes |

【次回1/19開催】FOCUSスパコンでのGaussian 09 利用講習会

平成26年度 「FOCUSスパコンでのGaussian 09 利用講習会」 を月1回

下記の内容にて催しますのでご案内いたします。

主催 : 公益財団法人 計算科学振興財団 (FOCUS)

日 時:

・【終了】 4月22日(火) 14時~16時

・【終了】 5月20日(火) 14時~16時

・【終了】 6月17日(火) 14時~16時

・【終了】 7月22日(火) 14時~16時

・【終了】 8月19日(火) 14時~16時

・【終了】 9月24日(水) 14時~16時

・【終了】 10月21日(火) 14時~16時

・【終了】 11月18日(火) 14時~16時

・【終了】 12月22日(月) 14時~16時

・【受付終了】 1月19日(月) 14時~16時

・【開催中止】 2月17日(火) 14時~16時

・【受付中】 3月17日(火) 14時~16時

場 所: 高度計算科学研究支援センター(計算科学センタービル) 2F 実習室

http://www.j-focus.or.jp/access.html

受講料:

賛助会員 10,800円

一般 21,600円

※ 受講料は、講習会終了後に請求書をお送りいたしますので、指定の口座に振込みをお願いいたします。

定員 : 20 名

概要:

FOCUSスパコンを実際に利用しながら、より少ない計算時間で正しい Gaussian 09 の計算結果を得るためのノウハウを身につけていただくことを目的とします。

一例として、CacheSize オプションの指定では最良と最悪のケースで実行時間が3割異なる場合がありました。

これらのノウハウを身につけることでFOCUS スパコンと Gaussian 09 の利用料を受講料以上節約していただけるようになることを期待しております。

プログラム:

0. SLURMを利用したGaussian 09 の実行方法

1. ノード内並列の効率的実行方法

1-1 並列数(%Nprocshared=)とメモリ指定(%mem=)

1-2 CacheSizeオプション

1-3 構造最適化からの振動数計算の手続き

2. Linda を用いたノード間並列の効率的実行方法

2-1 Linda 並列を実行する際のLSF スクリプト

2-2 プロセス数の %LindaWorker の指定と %Nprocshared の指定への割り振り

2-3 Model・property による Linda 並列の有効性

3. SCF が収束しない場合の対処法

4. 構造最適化が収束しない場合の対処法

5. 質疑応答

申し込み方法:

参加を希望される方は、request[at]j-focus.or.jp ([at]を@に変更して下さい)まで、

件名を 「FOCUSスパコンでのGaussian 09 利用講習会」 として、

以下の内容をご通知下さい。

================================

フリガナ :

お名前 :

ご所属 :

ご連絡先 :

参加希望講習会開催日 :

================================

参加申し込み締め切り:

講習会開催3業務日前AM10:00

H24年度の講習会開催報告

【7月24日】 FOCUSスパコンでのGaussian 09 利用講習会

【6月26日】 FOCUSスパコンでのGaussian 09 利用講習会

【5月22日】 FOCUSスパコンでのGaussian 09 利用講習会

【4月24日】 FOCUSスパコンでのGaussian 09 利用講習会

【次回2/2開催】「京」を中核とするHPCI活用を見据えたチューニング講習会 初級編

平成26年度 「京」を中核とするHPCI活用を見据えたチューニング講習会初級編を

下記の内容にて催しますのでご案内いたします。

主催 : 公益財団法人 計算科学振興財団 (FOCUS)

日 時:

・ 【終了】 6月 2日(月) 13時~15時

・ 【終了】 6月30日(月) 13時~15時

・ 【終了】 7月28日(月) 13時~15時

・ 【終了】 8月 4日(月) 13時~15時

・ 【終了】 8月25日(月) 13時~15時

・ 【終了】 9月 8日(月) 13時~15時

・ 【終了】 9月29日(月) 13時~15時

・ 【終了】 10月27日(月) 13時~15時

・ 【終了】 11月25日(火) 13時~15時

・ 【終了】 12月 8日(月) 13時~15時

・ 【終了】 12月26日(金) 10時~12時

・ 【受付終了】 1月26日(月) 10時~12時

・ 【受付中】 2月 2日(月) 10時~12時

・ 2月23日(月) 10時~12時

・ 3月 2日(月) 10時~12時

・ 3月23日(月) 10時~12時

場 所: 高度計算科学研究支援センター(計算科学センタービル) 2F実習室

http://www.j-focus.or.jp/access.html

参加費 : 無料

定員 : 20 名

概要 :

技術計算におけるチューニング技法の基本的な内容について講義します。

プログラム :

1. チューニングの基礎

2. コンパイルオプション

3. パフォーマンス測定方法

4. キャッシュチューニング

5. その他のチューニング

6. I/Oチューニング

7. チューニング手順

申し込み方法:

参加ご希望の方は、request[at]j-focus.or.jp ([at]を@に変更して下さい) まで、

件名を 「参加希望「京」を中核とするHPCI活用を見据えたチューニング講習会初級編」 として、

以下の内容をご通知下さい。

(中級編のノード内チューニング編、ノード間チューニング編も同時に申込可能です。送付のメール内にその旨ご連絡ください)

================================

フリガナ :

お名前 :

ご所属 :

ご連絡先 :

参加希望講習会開催日 :

================================

中級編の開催:

本講習会の内容を踏まえ、実習を行う

「京」を中核とするHPCI活用を見据えたチューニング講習会中級編(ノード内並列) を開催しております。

「京」を中核とするHPCI活用を見据えたチューニング講習会中級編(ノード間並列) を開催しております。

こちらのご参加も合わせてご検討ください。

参加申し込み締め切り:

講習会開催 5 業務日前 AM10:00

【次回2/2開催】「京」を中核とするHPCI活用を見据えたチューニング講習会中級編(ノード内チューニング編)

平成26年度 「京」を中核とするHPCI活用を見据えたチューニング講習会中級編(ノード内チューニング編) を

下記の内容にて催しますのでご案内いたします。

主催 : 公益財団法人 計算科学振興財団 (FOCUS)

日 時:

・【終了】 6月 2日(月) 15時~17時

・【終了】 6月30日(月) 15時~17時

・【終了】 7月28日(月) 15時~17時

・【終了】 8月 4日(月) 15時~17時

・【終了】 8月25日(月) 15時~17時

・【終了】 9月 8日(月) 15時~17時

・【終了】 9月29日(月) 15時~17時

・【終了】 10月27日(月) 15時~17時

・【終了】 11月25日(火) 15時~17時

・【終了】 12月 8日(月) 15時~17時

・【終了】 12月26日(金) 13時~15時

・【受付終了】 1月26日(月) 13時~15時

・【受付中】 2月 2日(月) 13時~15時

・ 2月23日(月) 13時~15時

・ 3月 2日(月) 13時~15時

・ 3月23日(月) 13時~15時

場 所: 高度計算科学研究支援センター(計算科学センタービル) 2F実習室

http://www.j-focus.or.jp/access.html

参加費 : 無料

定員 : 20 名

対象者 :

・「京」を中核とするHPCI活用を見据えたチューニング講習会初級編受講者

・ハイブリッドモデルのプログラミング技術を取得したい方

概要 :

1. アーキテクチャ

2. 並列プログミング

3. 共有メモリプログラミング

4. OpenMP

5. スレッドの同期操作

6. 実行時ライブラリー

7. 計算プログラム例

8. 実行方法

申し込み方法:

参加ご希望の方は、request[at]j-focus.or.jp ([at]を@に変更して下さい)まで、

件名を 「参加希望「京」を中核とするHPCI活用を見据えたチューニング講習会中級編(ノード内チューニング編)」 として、

以下の内容をご通知下さい。 (初級編、ノード間チューニング編も同時に申込可能です。送付のメール内にその旨ご連絡ください)

また、実習ではFX10を利用します。利用にあたり計算資源提供元に個人情報を提示する場合がございます。

================================

フリガナ :

お名前 :

ご所属 :

ご連絡先 :

参加希望講習会開催日 :

================================

初級編の開催:

中級編である本講習会前に初級編を受講いただくことが望ましいです。

初級編の内容、申込方法等についてはこちらをご覧ください。

参加申し込み締め切り:

講習会開催 5 業務日前 AM10:00

【次回2/2開催】「京」を中核とするHPCI活用を見据えたチューニング講習会 中級編(ノード間チューニング編)

平成26年度 「京」を中核とするHPCI活用を見据えたチューニング講習会中級編(ノード間) を

下記の内容にて催しますのでご案内いたします。

主催 : 公益財団法人 計算科学振興財団 (FOCUS)

日 時:

・ 【終了】 6月 3日(火) 13時~16時

・ 【終了】 7月 1日(火) 13時~16時

・ 【終了】 7月29日(火) 13時~16時

・ 【終了】 8月 5日(火) 13時~16時

・ 【終了】 8月26日(火) 13時~16時

・ 【終了】 9月 9日(火) 13時~16時

・ 【終了】 9月30日(火) 13時~16時

・ 【終了】 10月28日(火) 13時~16時

・ 【終了】 11月26日(火) 13時~16時

・ 【終了】 12月 9日(火) 13時~16時

・ 【終了】12月26日(金) 15時半~18時

・ 【受付終了】 1月26日(月) 15時~17時半

・ 【受付中】 2月 2日(月) 15時~17時半

・ 2月23日(月) 15時~17時半

・ 3月 2日(月) 15時~17時半

・ 3月23日(月) 15時~17時半

場 所: 高度計算科学研究支援センター(計算科学センタービル) 2F実習室

http://www.j-focus.or.jp/access.html

参加費 : 無料

定員 : 20 名

対象者 :

・「京」を中核とするHPCI活用を見据えたチューニング講習会初級編受講者

・ハイブリッドモデルのプログラミング技術を取得したい方

概要 :

1. 並列プログラム

2. メッセージ・パッシング・プログラム

3. MPI

4. プログラム例

5. コンパイル・リンク

6. 実行方法

申し込み方法:

参加ご希望の方は、request[at]j-focus.or.jp ([at]を@に変更して下さい) まで、

件名を 「参加希望「京」を中核とするHPCI活用を見据えたチューニング講習会中級編(ノード間チューニング編)」 として、

以下の内容をご通知下さい。(初級編、ノード内チューニング編も同時に申込可能です。送付のメール内にその旨ご連絡ください)

また、実習ではFX10を利用します。利用にあたり計算資源提供元に個人情報を提示する場合がございます。

ご了承の上お申し込みください。

================================

フリガナ :

お名前 :

ご所属 :

ご連絡先 :

参加希望講習会開催日 :

================================

初級編の開催:

中級編である本講習会前に初級編を受講いただくことが望ましいです。

初級編の内容、申込方法等についてはこちらをご覧ください。

参加申し込み締め切り:

講習会開催 5 業務日前 AM10:00

【3/12開催】インテル®Xeon Phi™コプロセッサー向け最適化・プログラミング実習

2014年度 「インテル®Xeon Phi™コプロセッサー向け最適化・プログラミング実習」を

下記の内容にて催しますのでご案内いたします。

【日 時】2015年3月12日(木) 13:20 - 16:30 (13:00 受付開始)

【申込み方法】

下記のURLからお申込み下さい。

http://www.xlsoft.com/jp/products/intel/tech/seminar/xeon_phi_focus.html?s=xl_i_event

【2/25開催】第4回 先進科学技術活力養成講座 by 神戸大学連携創造本部

入門ワークショップ ”FMO 計算法によるタンパク質~リガンド相互作用エネルギー解析”

を下記の内容にて催しますのでご案内いたします。

日 時: 2月25日(水) 10:00~17:00

場 所: 公益財団法人 計算科学振興財団

〒650-0047 兵庫県神戸市中央区港島南町7-1-28 計算科学センタービル 2F実習室

http://www.j-focus.or.jp/access.html

主 催: 神戸大学連携創造本部

共 催: 公益財団法人 計算科学振興財団

後 援: CBI学会 みずほ情報総研株式会社 株式会社菱化システム

参加費: 無料

定 員: 10名程度

対象者: 構造ベース創薬に関心をお持ちの大学院生、企業・アカデミアの研究者、創薬プロジェクト関係者等

概 要: セミナー「FMO計算法の創薬への応用」(H27.2.10開催)に引き続き、

http://www.innov.kobe-u.ac.jp/innov-hum-dev/life/ist/pdf/senshin3rd20150210.pdf

計算科学振興財団との共催により、“PDB・電子密度データの入手”から

“FMOによる配位エネルギー解析”までの手順の実際に興味をお持ちの方を対象にハンズオン・ワークショップです。

プログラム使用経験のない方も含め、“タンパク質~リガンド相互作用エネルギー解析”に関心をお持ちの研究者

(計算化学、創薬・合成化学者、構造生物科学者等)を対象にしていますので、FMO計算法利用の一連の手順を学ぶ

入門ワークショップとしてお気軽にご参加下さい。

プログラム:

10:00~12:30 実習 1.MOEの概要説明

2.PDBデータと電子密度データの取得

3.構造データの確認と修正

4.水素原子付加作業

5.FMO用構造データ作成

13:30~17:00 実習 1.MIZUHO/BioStation の概要説明

2.FMO計算入力データの作成

3.FOCUSスパコンで計算

4.FMO解析結果の評価

5.VISCANAによる化合物クラスタリング(講義)

申込方法:

参加ご希望の方は、hicd-tiiki-life[at]office.kobe-u.ac.jp ([at]を@に変更して下さい)

神戸大学連携創造本部 冨井まで、件名を 「参加希望 第4回 先進科学技術活用力養成講座」 として、

以下の内容をご通知下さい。

先着順にて事務局よりご連絡いたします。

==========================================================

フリガナ:

お名前:

ご所属:

メールアドレス:

電話番号:

専門分野:計算化学、創薬・合成化学、構造生物学 等 から該当する分野すべて

===========================================================

リンク先

http://www.innov.kobe-u.ac.jp/innov-hum-dev/life/ist/pdf/senshin4th20150225.pdf

申込締切: 2015 年2 月20 日(金)

これに関連して2月10日に開催されます「第3回 先進科学技術活用力養成講座」へのご参加も同様に受け付けております。

リンク先

http://www.innov.kobe-u.ac.jp/innov-hum-dev/life/ist/pdf/senshin3rd20150210.pdf

PDF版 FOCUSスパコン利用の手引き

4.6.課金確認コマンド

目次 (4.6.課金確認コマンド)

4.6. 課金確認コマンド

4.6.1. プロジェクト単位従量課金確認コマンド thismonth

4.6.2. 利用者単位従量課金確認コマンド uacct

4.6.3. 利用者単位アプリケーション課金確認コマンド uacct_apl

4.6.4. 課金確認コマンドの情報反映タイミング

4.6. 課金確認コマンド

4.6.1. プロジェクト単位従量課金確認コマンド thismonth

基本サービスでの当月初めからの終了ジョブに対する従量課金額等の情報が得られます。

thismonth(引数無し)で当月の情報が、thismonth YYYYMM で西暦と月を与えると該当年月の情報が得られます。

【実行例1】

|

$ thismonth Charge information of *** in this month. system njob avg_et avg_nodes avg_procs et_nodes charge et_max et_np_max np_max A 62 0.0 5.0 60.6 9.1 641.5 0.5 54.3 1200 B 44 0.0 1.6 20.0 1.5 152.8 0.3 4.7 32 C 37 0.0 1.9 22.4 1.1 89.1 0.2 5.1 48 D 44 0.1 4.4 87.7 17.2 5154.8 2.5 202.3 1200 E 38 0.0 1.3 26.8 0.7 1806.8( 401.5) 0.2 3.1 40 TOTAL: 7845 yen |

【実行例2】

|

$ thismonth 201404 Charge information of *** in this month. system njob avg_et avg_nodes avg_procs et_nodes charge et_max et_np_max np_max A 62 0.0 5.0 60.6 9.1 641.5 0.5 54.3 1200 B 44 0.0 1.6 20.0 1.5 152.8 0.3 4.7 32 C 37 0.0 1.9 22.4 1.1 89.1 0.2 5.1 48 D 44 0.1 4.4 87.7 17.2 5154.8 2.5 202.3 1200 E 38 0.0 1.3 26.8 0.7 1806.8( 401.5) 0.2 3.1 40 TOTAL: 7845 yen |

<出力説明>

| system | システム名 |

| njob | ジョブ数 |

| avg_et | 平均経過時間(h) |

| avg_nodes | 平均ノード数 |

| avg_procs | 平均プロセス数 |

| et_nodes | ノード時間(h) |

| charge | 課金額(円) ※カッコ内はFOCUS賛助会員の価格 |

| et_max | 最大経過時間(h) |

| et_np_max | 最大プロセスノード時間(h) |

| np_max | 最大プロセス数 |

<注意>

トライアルユース額は反映されておりません。また、実行中のジョブは結果に反映されません。

4.6.2. 利用者単位従量課金確認コマンド uacct

基本サービスでの終了ジョブに対する従量課金額等の情報が得られます。

uacct(引数無し)で当月の情報が、uacct YYYYMM で西暦と月を与えると該当年月の情報が得られます。

【実行例1】

|

$ uacct Charge information of afse0025 in 201404 : Computational: 7842 (Rack rate: 7842) Items A: 9 nodehours, 641 yen B: 1 nodehours, 152 yen C: 1 nodehours, 89 yen D: 17 nodehours, 5154 yen E: 0 nodehours, 1806 yen (401 yen) ===================================================== Total charge : 7842 |

【実行例2】

|

$ uacct 201404 Charge information of afse0025 in 201404 : Computational: 7842 (Rack rate: 7842) Items A: 9 nodehours, 641 yen B: 1 nodehours, 152 yen C: 1 nodehours, 89 yen D: 17 nodehours, 5154 yen E: 0 nodehours, 1806 yen (401 yen) ===================================================== Total charge : 7842 |

<出力説明>

| Computational: | 演算ノード課金額 |

| Rack rate: | 演算ノード割引前課金 |

| Items | 内訳 |

| A : | A システム ノード時間、課金額 |

| B : | B システム ノード時間、課金額 |

| C : | C システム ノード時間、課金額 |

| D : | D システム ノード時間、課金額 |

| E : | E システム ノード時間、課金額 ※カッコ内はFOCUS賛助会員の価格 |

| Total charge | 合計課金額 |

<注意>

トライアルユース額は反映されておりません。また、実行中のジョブは結果に反映されません。

4.6.3. 利用者単位アプリケーション課金確認コマンド uacct_apl

Gaussian 09, MIZUHO/BioStation, Parallel CONFLEXの従量課金額等の情報が得られます。

uacct_apl(引数無し)で当月の情報が、uacct_apl YYYYMMで西暦と月を与えると該当年月の情報が得られます。

【実行例1】

|

$ uacct_apl Charge information of uits0022 in 201407 : Computational: 340 (Rack rate: 340) Items Gaussian 09: 2 nodehours, 337 yen MIZUHO/BioStation: 0 nodehours, 3 yen Parallel CONFLEX: 0 nodehours, 0 yen ===================================================== Total charge : 340 |

【実行例2】

|

$ uacct_apl 201406 Charge information of uits0022 in 201406 : Computational: 54 (Rack rate: 54) Items Gaussian 09: 0 nodehours, 51 yen MIZUHO/BioStation: 0 nodehours, 1 yen Parallel CONFLEX: 0 nodehours, 2 yen ===================================================== Total charge : 54 |

<出力説明>

| Computational: | 課金額 |

| Rack rate: | 割引前課金 |

| Items | 内訳 |

| Gaussian 09 : | Gaussian 09 ノード時間、課金額 |

| MIZUHO/BioStation : | MIZUHO/BioStation ノード時間、課金額 |

| Parallel CONFLEX : | Parallel CONFLEX ノード時間、課金額 |

| Total charge | 合計課金額 |

<注意>

トライアルユース額は反映されておりません。また、実行中のジョブは結果に反映されません。

4.6.4. 課金利用コマンドの情報反映タイミング

課金確認コマンドは、ジョブ実行履歴データを利用して課金計算を行っています。

ジョブ実行履歴データは毎日0時の時点で終了しているジョブを反映します。

その為、課金コマンドを実行するタイミングにより課金計算に含まれないジョブが存在する場合があります。

(例1)7月9日14:00に終了したジョブは、7月10日0:00以降に課金確認コマンドに反映されます。

(例2)7月10日0:00時点で実行中のジョブは7月10日の課金確認コマンドには未反映となります。

課金コマンドで利用するジョブ実行履歴データは、下記のディレクトリに保存されます。

/home1/[利用グループ]/AccountingLog

アカウント毎に日付、実行システムのファイルが存在します。

[日付(YYYYMMDD)]_[ユーザーアカウント]_[システム名]_acct.log

【実行例1】

|

$ cat /home1/gxxx/AccountingLog/20140721_uxxx0001_ABC_acct.log JobId YYYYMMDDhhmmss WaitTime ElapsedTime NumNodes NumProcs UserName Queue 38422 20140721103930 29 5 1 12 uxxx0001 a024h 38492 20140721155016 21 31 3 36 uxxx0001 a024h 38493 20140721155148 5 33 3 36 uxxx0001 a024h 38507 20140721161147 7 32 2 24 uxxx0001 a024h |

【実行例2】

|

$ cat /home1/gxxx/AccountingLog/20140721_uxxx0001_DEG_acct.log JobId YYYYMMDDhhmmss WaitTime ElapsedTime NumNodes NumProcs UserName Queue 38662 20140721080010 0 9 1 12 uxxx0001 debug6m 38667 20140721120010 0 9 1 12 uxxx0001 debug6m 38687 20140721160010 0 9 1 12 uxxx0001 debug6m 38699 20140721200010 0 9 1 12 uxxx0001 debug6m |

<ファイル内容説明>

| JobId | : ジョブID |

| YYYYMMDDhhmmss | : ジョブ完了日時 |

| WaitTime | : CPU待ち時間(秒) |

| ElapsedTime | : 実行時間(秒) |

| NumNodes | : ノード数 |

| NumProcs | : プロセス数 |

| UserName | : ユーザーアカウント |

| Queue | : 利用キュー名 |

FOCUSスパコンシステムに関するお知らせ

【次回2/5開催】FOCUSスパコン利用講習会(基本コース)

平成26年度 「FOCUSスパコン利用講習会(基本コース)」 を月2回

下記の内容にて催しますのでご案内いたします。

FOCUSスパコンシステムの概要説明し、受講者には

インターネット経由でFOCUSスパコンへログイン、ジョブの投入を実習していただきます。

また、「FOCUSスパコン利用講習会(応用コース)」を同日開催いたします。

あわせての参加をご検討ください。

日 時:

・【終了】 4月21日(木) 13時~15時

・【終了】 4月24日(木) 13時~15時

・【終了】 5月 8日(木) 13時~15時

・【終了】 5月15日(木) 13時~15時

・【終了】 6月 5日(木) 13時~15時

・【終了】 6月12日(木) 13時~15時

・【終了】 7月 3日(木) 13時~15時

・【終了】 7月17日(木) 13時~15時

・【終了】 8月 7日(木) 13時~15時

・【終了】 8月14日(木) 13時~15時

・【終了】 9月 4日(木) 13時~15時

・【終了】 9月19日(金) 13時~15時

・【終了】 10月 2日(木) 13時~15時

・【終了】 10月16日(木) 13時~15時

・【終了】 11月 6日(木) 13時~15時

・【終了】 11月13日(木) 13時~15時

・【終了】 12月 4日(木) 13時~15時

・【終了】 12月19日(金) 13時~15時

・【終了】 1月 8日(木) 13時~15時

・【終了】 1月22日(木) 13時~15時

・【受付終了】 2月 5日(木) 13時~15時

・【受付中】 2月19日(木) 13時~15時

・ 3月 5日(木) 13時~15時

・ 3月19日(木) 13時~15時

場 所: 高度計算科学研究支援センター(計算科学センタービル) 2F 実習室

http://www.j-focus.or.jp/access.html

参加費: 無料

定員 : 20名

※初参加者を優先とさせていただきます。

プログラム:

1 ご挨拶

2 FOCUSスパコンシステム構成

2.1 各システム(ABCDEGシステム)の特徴

2.2 各システムのノードスペック

2.3 ソフトウェア

3 システムへのログイン(実習)

3.1 鍵交換によるSSH接続

3.1.1 TeraTermによるSSHログイン

3.1.2 ディレクトリ構成確認

3.1.3 クォータ確認コマンド

3.1.4 WinSCPによるファイル転送

3.2 SSL-VPN接続

3.2.1 cisco AnyConnect Secure Mobility Client のインストール

3.2.2 パスワード変更

3.3.3 TeraTermによるSSHログイン

4 ジョブ実行(実習)

4.1 環境設定

4.2 サンプルソースのコンパイル

4.3 SLURMからの逐次ジョブの投入

4.4 fjコマンドの紹介

5 利用お問合せシステムOKBizの紹介

5.1 ユーザ情報の変更

5.2 質問、作業依頼投稿方法

申し込み方法:

参加を希望される方は、request[at]j-focus.or.jp ([at]を@に変更して下さい)まで、

件名を 「FOCUSスパコン利用講習会(基本コース)」 として、

以下の内容をご通知下さい。

================================

フリガナ :

お名前 :

ご所属 :

ご連絡先 :

参加希望講習会開催日 :

================================

参加申し込み締め切り:

講習会開催3業務日前AM10:00

4.1.キュー

目次 (4.1.キュー)

4.1. キュー

4.1.1. キューの一覧

4.1.2. キュー情報の確認方法

4.1.3. 利用可能なノード数の確認方法

4.1.キュー

4.1.1.キューの一覧

フロントエンドサーバから演算ノードに対して、ジョブを投入できるキューの一覧を示します。

表4.1.1 キューの一覧

| キュー名 | 最大ジョブ数 | 最大ジョブ投入数 | 最長実行時間 | 最大ノード数(※) | ジョブあたり最大ノード数(※) | システム | 備考 |

| a024h | 未設定 | 無制限 | 24時間 | 224 | 224 | A | |

| a096h | 未設定 | 5/ユーザ | 96時間 | 50 | 50 | A | |

| b024h | 未設定 | 無制限 | 24時間 | 2 | 2 | B | |

| b096h | 未設定 | 5/ユーザ | 96時間 | 1 | 1 | B | |

| c024h | 未設定 | 無制限 | 24時間 | 22 | 22 | C | |

| c096h | 未設定 | 5/ユーザ | 96時間 | 11 | 11 | C | |

| d006h | 未設定 | 無制限 | 6時間 | 112 | 112 | D | |

| d012h | 未設定 | 無制限 | 12時間 | 112 | 112 | D | |

| d024h | 未設定 | 無制限 | 24時間 | 80 | 80 | D | |

| d072h | 未設定 | 5/ユーザ | 72時間 | 32 | 32 | D | |

| e024h | 未設定 | 無制限 | 24時間 | 48 | 16 | E | |

| e072h | 未設定 | 5/ユーザ | 72時間 | 24 | 8 | E | |

| debug6m | 未設定 | 5/ユーザ | 6分 | 4 | 2 | G | デフォルトキュー |

※最大ノード数は計算資源の予約状況により変動します。

(1)デフォルトキューは「debug6m」となります。ジョブ実行時にキュー名が省略された場合「debug6m」で実行されます。

(2)実際に本システムを利用する際には、sinfo -s コマンドで利用できるキュー名を確認して下さい。

(3)キューのノード実行状況を確認する際には、squeuesコマンドで確認して下さい。

4.1.2.キュー情報の確認方法

ジョブ投入先のキュー名を確認するには、sinfoコマンドを実行します。

| $ sinfo -s |

【実行例】

|

$ sinfo -s |

<出力説明>

| PARTITION | キュー名(パーティション名) |

| AVAIL | キューの状態(up or inact) |

| TIMELIMIT | 最大実行時間 |

| NODES(A/I/O/T) | ノードの状態(allocated/idle/other/total) |

| NODELIST | キュー(パーティション)に割り当てられたノード |

キューのノード実行状況を確認するには、squeuesコマンドを実行します。

注意:SLURMの標準コマンドのsqueueとは別コマンドです。

| $ squeues |

【実行例】

|

$ squeues |

<出力説明>

| QUEUE_NAME | キュー名(パーティション名) |

| TIMELIMIT | 最大実行時間 |

| STATUS | キューの状態(up or inact) |

| MAXNODES | 最大ノード数 |

| NNODES | 実行中及び実行待ちのジョブが要求しているノード数 |

| PEND | 実行待ちのジョブが要求しているノード数 |

| RUN | 実行中のノード数 |

4.1.3.利用可能なノード数の確認方法

空きノード数を確認するfreenodesというコマンドを用意しています。ジョブ投入のための空きノード数の確認の目安にご利用ください。

| $ freenodes |

【出力形式】

|

Number of free nodes in A sys. with FDR-IB connected is 空きノード数 / 提供最大ノード数. Number of free nodes in B sys. with FDR-IB connected is 空きノード数 / 提供最大ノード数. Number of free nodes in C sys. with GbE connected is 空きノード数 / 提供最大ノード数. Number of free nodes in D sys. with FDR-IB connected is 空きノード数 / 提供最大ノード数. Number of free nodes in E sys. with FDR-IB connected is 空きノード数 / 提供最大ノード数. Number of free nodes in G sys. with GbE connected is 空きノード数 / 提供最大ノード数. |

【実行例】

|

$ freenodes |

4.4.ジョブ投入スクリプトの作成

目次 (4.4.ジョブ投入スクリプトの作成)

4.4. ジョブ投入スクリプトの作成

4.4.1. 処理方法の指定

4.4.2. sbatchオプション

4.4.3. 環境変数

4.4.4. 逐次ジョブを実行する場合

4.4.5. スレッド並列ジョブを実行する場合

4.4.6. MPIプログラム(openMPI)を実行する場合

4.4.7. MPIプログラム(Intel MPI)を実行する場合

4.4.8. MPIプログラム(mpich2)を実行する場合

4.4. ジョブ投入スクリプトの作成

ジョブ投入のためのジョブ投入スクリプトを作成します。

4.4.1. 処理方法の指定

ジョブ投入スクリプトの中で“#SBATCH”で始まる行にsbatch オプションを記述すると、処理方法を指定することができます。

4.4.2. sbatch オプション

主なsbatch オプションを次に示します。

表 4.4.2 sbatch オプション

| ジョブ投入スクリプトのディレクティブ | #SBATCH |

|---|---|

| キュー(パーティション)指定 | -p [queue] |

| 実行ノード数(並列数の指定) | -N [minnodes[-maxnodes]], --nodes=[minnodes[-maxnodes]] |

| CPU 数の指定(プロセス数の指定) | -n [number], --ntasks=[number] |

| 実行時間の上限指定(wall time) |

-t [minutes], --time=[minutes] |

| 出力ファイル指定 | -o [filename], --output=[filename] |

| エラー出力指定 | -e [filename], --error=[filename] |

| 出力・エラー出力の総合出力 | (-e 指定無しで-o を使用) |

| イベント通知 |

--mail-type=[type] ※type はBEGIN, END, FAIL, REQUEUE, ALL のいずれか |

| メールアドレス指定 | --mail-user=[address] |

| ジョブ再投入 | --requeue または --no-requeue(未指定時は--no-requeue) |

| 実行ディレクトリ指定 | --workdir=[dir_name] |

| メモリサイズ指定 | --mem=[mem][M|G|T] OR --mem-per-cpu=[mem][M|G|T] |

| ノード当たりのタスク数指定 | --tasks-per-node=[count] |

| タスク当たりのCPU数指定 | --cpus-per-task=[count] |

| 依存ジョブ |

--dependency=[type:job_id]

type には次の依存タイプを指定できます。 |

| ジョブのプロジェクト化 | --wckey=[name] |

| ジョブ実行ホストの詳細 | --nodelist=[nodes] AND/OR --exclude=[nodes] |

| アレイジョブ | --array=[array_spec] |

| 開始時間指定 | --begin=YYYY-MM-DD[THH:MM[:SS]] |

4.4.3. 環境変数

sbatch コマンド実行時、ジョブ実行時に環境変数が設定されます。設定される主な環境変数を示します。

表 4.4.3 環境変数

| 環境変数 | 内容 |

|---|---|

|

SLURM_JOB_CPUS_PER_NODE |

ジョブ実行に使用されるホストとプロセス数のリスト |

| SLURM_JOB_ID | ジョブID |

| SLURM_JOB_NAME | fjsub –N やsbatch -J で指定したジョブ名。ジョブ名を指定していない場合は、実際に指定されたコマンド列が格納されます。 |

| SLURM_JOB_NODELIST | ジョブが実行されるホスト名のリスト |

| SLURM_NTASKS | sbatch –n(または ––ntasks)で指定したプロセス数 |

| SLURM_SUBMIT_DIR | ジョブ が投入されたカレントディレクトリ |

4.4.4. 逐次ジョブを実行する場合

逐次(並列計算を行わない方式)で実行する時に作成するジョブ投入スクリプトの例を示します。

|

#!/bin/bash #SBATCH -p d024h ・・・・・・・・・・ (1) #SBATCH -n 1 ・・・・・・・・・・ (2) #SBATCH -J test_serial ・・・・・・・・・・ (3) #SBATCH -o stdout.%J ・・・・・・・・・・ (4) #SBATCH -e stderr.%J ・・・・・・・・・・ (5) ./a.out ・・・・・・・・・・ (6) |

(1) パーティション名(キュー名)を指定します。

(2) ジョブで使用するプロセス数(-n もしくは--ntasks=<number>)を指定します。

逐次ジョブの場合、プロセス数は1 となりますので、指定値は“-n 1”を指定します。

(3) ジョブ名を指定します。

(4) 標準出力ファイルを指定します。%J はジョブID に変換されます。

(5) 標準エラー出力ファイルを指定します。%J はジョブID に変換されます。

(6) プログラム(a.out)を実行します。

4.4.5. スレッド並列ジョブを実行する場合

スレッド並列(単体ノードで並列計算を行う方式)でジョブを実行する時に作成するジョブ投入スクリプトの例を示します。

|

#!/bin/bash #SBATCH -p d024h ・・・・・・・・・・ (1) #SBATCH -n 1 ・・・・・・・・・・ (2) #SBATCH -c 20 ・・・・・・・・・・ (3) #SBATCH -J test_openmp ・・・・・・・・・・ (4) #SBATCH -o stdout.%J ・・・・・・・・・・ (5) #SBATCH -e stderr.%J ・・・・・・・・・・ (6) export OMP_NUM_THREADS=${SLURM_CPUS_PER_TASK} ・・・・・・・・・・ (7) ./a.out ・・・・・・・・・・ (8) RETCODE=$? exit ${RETCODE} ・・・・・・・・・・ (9) |

(1) パーティション名(キュー名)を指定します。

(2) ジョブで使用するプロセス数(-n もしくは--ntasks=<number>)を指定します。

上記の例では、1 プロセスで実行するために-n 1 を指定しています。

(3) ジョブで使用するCPU数(-cもしくは—cpus-per-task=<number>)を指定します。

上記の例では、20スレッドで実行するために-c 20を指定しています。

(4) ジョブ名を指定します。

(5) 標準出力ファイルを指定します。%J はジョブID に変換されます。

(6) 標準エラー出力ファイルを指定します。%J はジョブID に変換されます。

(7) 環境変数 OMP_NUM_THREADS にスレッド数を指定します。

(8) プログラム(a.out)を実行します。

(9) プログラムの戻り値をSLURM に戻します。

4.4.6. MPI プログラム(openMPI)を実行する場合

プロセス並列(複数のノードで並列計算を行う方式)のジョブをOpenMPI で実行する時に作成するジョブ投入スクリプトの例を示します。

下記スクリプトでは、Dシステムにて2ノード(1ノードあたり2プロセス)のジョブが生成されます。

|

#!/bin/bash #SBATCH -p d024h ・・・・・・・・・・ (1) #SBATCH -n 40 ・・・・・・・・・・ (2) #SBATCH -J test_openmpi ・・・・・・・・・・ (3) #SBATCH -o stdout.%J.log ・・・・・・・・・・ (4) #SBATCH -e stderr.%J.log ・・・・・・・・・・ (5) module load gnu/openmpi165 ・・・・・・・・・・ (6) mpirun -np ${SLURM_NTASKS} ./a.out ・・・・・・・・・・ (7) RETCODE=$? exit ${RETCODE} ・・・・・・・・・・ (8) |

(1) パーティション名(キュー名)を指定します。

(2) ジョブで使用するプロセス数(-n もしくは--ntasks=<number>)を指定します。

(3) ジョブ名を指定します。

(4) 標準出力ファイルを指定します。%J はジョブID に変換されます。

(5) 標準エラー出力ファイルを指定します。%J はジョブID に変換されます。

(6) MPI 環境変数をセットします。

(7) プログラム(a.out)を実行します。

(8) プログラムの戻り値をSLURM に戻します。

上記(6)については、次の実行方法があります。

|

標準GNU コンパイラー (GNU 4.4.7) |

OpenMPI | module load gnu/openmpi165 |

| MPICH2 | module load gnu/mpich2141p1 | |

| IntelMPI | module load impi411 | |

| GNU4.8.2 コンパイラー | OpenMPI |

module load PrgEnv-gnu482 module load gnu/openmpi165 |

| MPICH2 |

module load PrgEnv-gnu482 module load gnu/mpich2141p1 |

|

| IntelMPI |

module load PrgEnv-gnu482 module load impi411 |

|

| Intel コンパイラー | OpenMPI |

module load PrgEnv-intel module load intel/openmpi165 |

| MPICH2 |

module load PrgEnv-intel module load intel/mpich2141p1 |

|

| IntelMPI |

module load PrgEnv-intel module load impi411 |

4.4.7. MPI プログラム(Intel MPI)を実行する場合

プロセス並列(複数のノードで並列計算を行う方式)のジョブをIntelMPI で実行する時に作成するジョブ投入スクリプトの例を示します。

|

#!/bin/bash #SBATCH -p d024h #SBATCH -n 40 #SBATCH -J test_intelmpi #SBATCH -o stdout.%J.log #SBATCH -e stderr.%J.log module load PrgEnv-intel module load impi411 NODEFILE=`generate_pbs_nodefile` mpirun -np ${SLURM_NTASKS} ./a.out |

(注) インテルコンパイラで作成された実行ファイルを実行する場合、ジョブ投入スクリプト内に

|

module load PrgEnv-intel module load impi411 |

の行を記載する必要があります。

4.4.8. MPI プログラム(mpich2)を実行する場合

プロセス並列(複数のノードで並列計算を行う方式)のジョブをGNU コンパイラで作成したMPI プログラム(mpich2)で実行する時に作成するジョブ投入スクリプトの例を示します。

|

#!/bin/bash #SBATCH -p d024h #SBATCH -n 40 #SBATCH -J test_gnu #SBATCH -o stdout.%J.log #SBATCH -e stderr.%J.log module load PrgEnv-gnu482 module load gnu/mpich2141p1 NODEFILE=`generate_pbs_nodefile` mpirun -np ${SLURM_NTASKS} ./a.out |

(注) GNU コンパイラが用意するmpich2 環境を利用し、GNU コンパイラで作成された実行ファイルを実行する場合、ジョブ投入スクリプト内に

|

module load PrgEnv-gnu482 module load gnu/mpich2141p1 |

の行を記載する必要があります。